Hochrechnung

Razzia wegen Schmuggelkriminalität: Frankfurter Anwalt festgenommen hessenschau.de

Bei einer Großrazzia gegen mutmaßliche Schmuggler durchsuchte die...

Tech

GTA VI: Spielveröffentlichung noch verschoben? Spieler sind bereits in PLS

Veröffentlicht im September 2013...

Arkane’s Prey ist derzeit im Epic Games Store erhältlich

Arkan Studios'Prey ist derzeit als kostenloser Download im Rahmen von Epischer SpieleladenAngebot "15 Tage kostenlose Spiele".

Science-Fiction-Film Kostenlos erhältlich Für 24 Stunden, wobei das Gewinnspiel...

FIFA 22 enthüllt sein Cover, den ersten Trailer dieses Wochenende

Euro 2020 und Copa America haben ihr Urteil noch nicht gefällt, dass Electronic Arts beschlossen hat, über das nächste Fußballspiel zu kommunizieren. Erster...

ECONOMY

Le 1er fevrier 2022, le taux d’intérêt de votre „livret A“ consacré à l’épa

Comme partout en France, le "livret A" reste le place préféré des Guadeloupeens et des Martiniquais. Ce compte d'épargne est sans frais et...

Auge. Boge „ahnt Gefahren“ nach Anschlag auf Atomkraftwerk in der Ukraine

Fall Nr. 1: Sie (oder jemand anderes) verwenden mehr als $this.View.AuthResponse.DeviceLimit-Geräte und/oder Browser gleichzeitig →Melden Sie sich von Geräten und/oder Browsern ab, die Sie...

Die Entdeckung kleiner Knochen und Zähne zeigt die Existenz mehrerer Arten von Dinosauriern, die...

Dies ist eine künstlerische Darstellung eines Tyrannosaurus mit seinen Jungen. Bildnachweis: James Havens

In den 1950er Jahren machten Forscher die ersten unerwarteten Entdeckungen von...

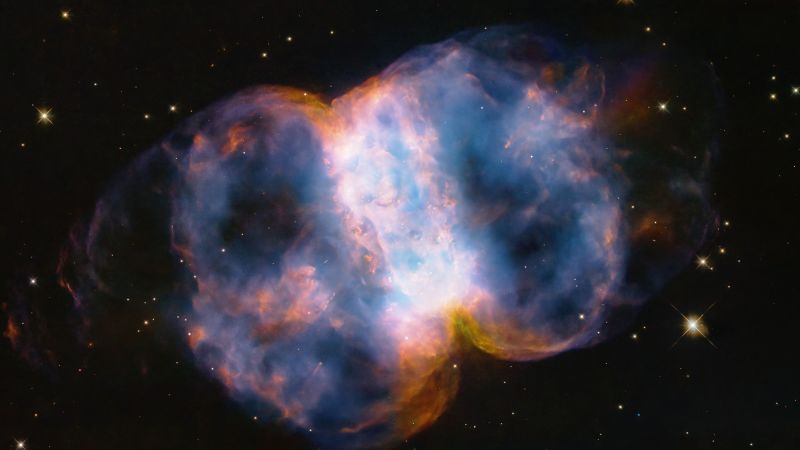

Dieses atemberaubende Video zeigt die bisher größte und detaillierteste Simulation des frühen Universums

Kleiner Clip zur Simulation von Thesan. Sehen Sie sich das Video im folgenden Artikel an.

Benannt nach der Göttin der Morgendämmerung, helfen Thesans Simulationen...

ENTERTAINMENT

Camille Lacourt spielt „Bière sur Bière“ Après sa Rupture mit Valérie Bègue

In einem veröffentlichten Interview auf dem Instagram-Konto von Kool Mag, Camille Lacourt, wurde sie am 6. April 2016 von Valérie Bègue getrennt, als sie...

Corinne Tozet: Dieses Detail an der Schauspielerin, das ihre 27-jährige Tochter aufregt

Diesen Montag, den 27. Juni 2022, ist Corinne Tozet zurück TF1 In...

Leo Today, Leo 3. Juni 2021: Vorhersagen für Ihr Horoskop in Gesundheit, Liebe und...

Lima 2. Juni 2021Aktualisiert am 06.02.2021 22:00Wettervorhersage für Donnerstag, 3. Juni 2021Arbeite und arbeite dafür Horoskopkarte Von Leo: Arbeit und Geschäft:...

Bruno (Les 12 coups de midi) enthüllt, wie Faustine Bollaert und ihr Ehemann Maxime...

Nach einer olympischen Winterpause feierte Faustin Bollaert am Montag, den 21. Februar, in France 2 ein großes Comeback. Der Gastgeber übernahm das Spiel, das...

SCIENCE

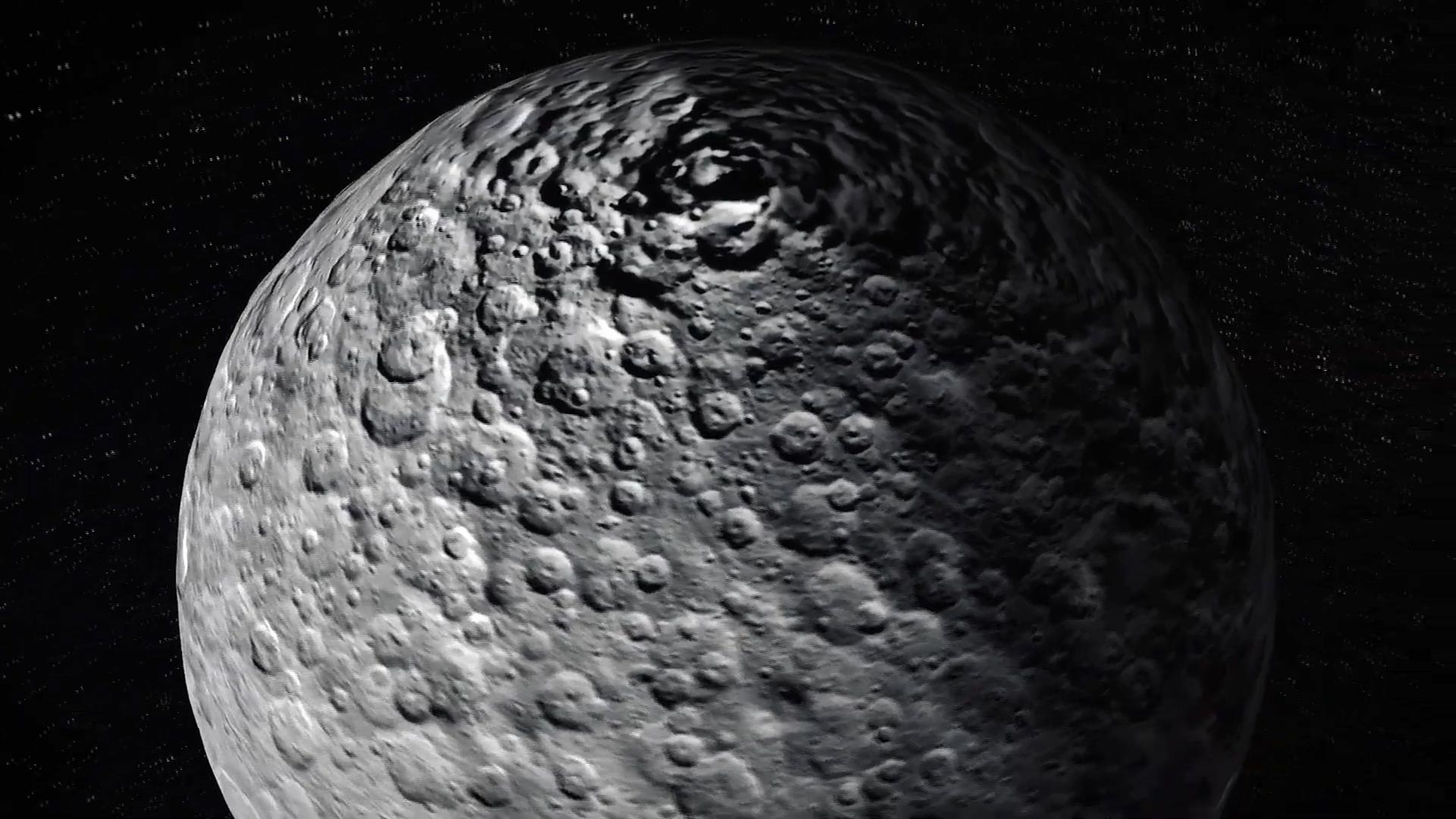

Der Zwergplanet Ceres in seiner hellsten Form

Ein Bild des Zwergplaneten Ceres, das auf Beobachtungen der NASA-Raumsonde Dawn basiert. In diesem Monat ist der Zwergplanet Ceres am hellsten, was bedeutet,...

NEUESTE ARTIKEL

Latest article

In den USA wurden vier weitere Katzen positiv auf die Vogelgrippe H5N1 getestet

Vier weitere Katzen seien im Zusammenhang mit einem zunehmenden Ausbruch bei Milchkühen in den Vereinigten Staaten positiv auf das Vogelgrippevirus H5N1 getestet worden, sagten...

Experten betrachten Trumps Prozess mit Argwohn

StartseitePolitikStand: 26. April 2024, 13:55 Uhraus: Fabian MüllerEr drücktTeiltDerzeit laufen in den USA mehrere Prozesse gegen Donald Trump. Anwälte gehen davon aus, dass...

:quality(75)/cloudfront-us-east-1.images.arcpublishing.com/elcomercio/CKW4NOY7QVFMDAYNIXJ7IMUIGI.jpg)