Hochrechnung

Das Mixed-Jumping-Team belegte bei der Deutschen Weltmeisterschaft den achten Platz

Das tschechische gemischte Team erreichte zum ersten Mal im Skispringen die zweite Runde der Weltmeisterschaft. Carolina Indrakova, Victor Polik, Clara Ulrichova und...

Tech

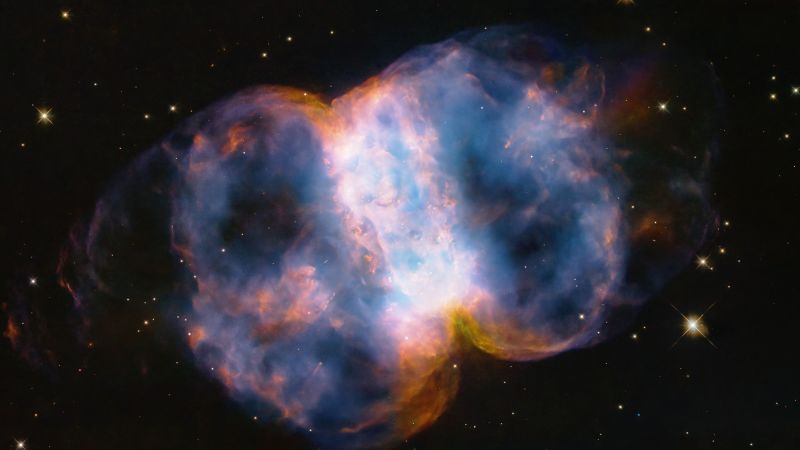

Diese Entdeckung bestätigt einmal mehr Einsteins erstaunliche Fortschritte während seiner Zeit

Zum ersten Mal konnten Astronomen die Rückseite eines Schwarzen Lochs sehen und damit beweisen, dass Albert Einstein mehr als ein Jahrhundert später tatsächlich Recht...

September Club-Inhalte enthüllt

Wie jeden Monat fügt Epic Games seinem monatlichen Angebot einen neuen Look hinzu. Club D FortniteAuf der Gans liegt das gleichnamige goldene Ei. ...

Auf dem M1.-Chip wurde ein neuer Fehler namens „Augury“ entdeckt

⏰ Gestern um 20:20 Uhr.

Mehdi Nitmazi

Reaktion

Nach der Untersuchung der...

ECONOMY

Economy Seven Diesen Dienstag, 1. März

Wir teilen Highlights über die Wirtschaft und das Geschäft, die am Dienstag, den 1. März beginnen.

1. Petróleos Mexicanos (Pemex) hat im Jahr 2021 einen...

Die Toilette verwandelt Abfall in virtuelle Energie und Geld

Es gibt ein beliebtes Video des Kinderprogramms 31 Minuten, in dem die Figur Juan Carlos Puduc erklärt "Stuhlweg“ und erklärt, wie menschliche Fäkalien einen...

Gute Zahlen für die Gemeinden von Joura im Jahr 2019

Das kumulierte Geschäftsjahr 2019 der 53 Gemeinden von Goura weist ein positives Ergebnis von 2,7 Millionen Franken aus. Die Leistung ist hauptsächlich auf...

Petition zur Ausweisung der Geliebten von Wladimir Putin

Alina Kabaeva gilt als Fan des russischen Präsidenten Wladimir Putin. Während des Kriegsausbruchs in der Ukraine soll der 38-Jährige ein luxuriöses...

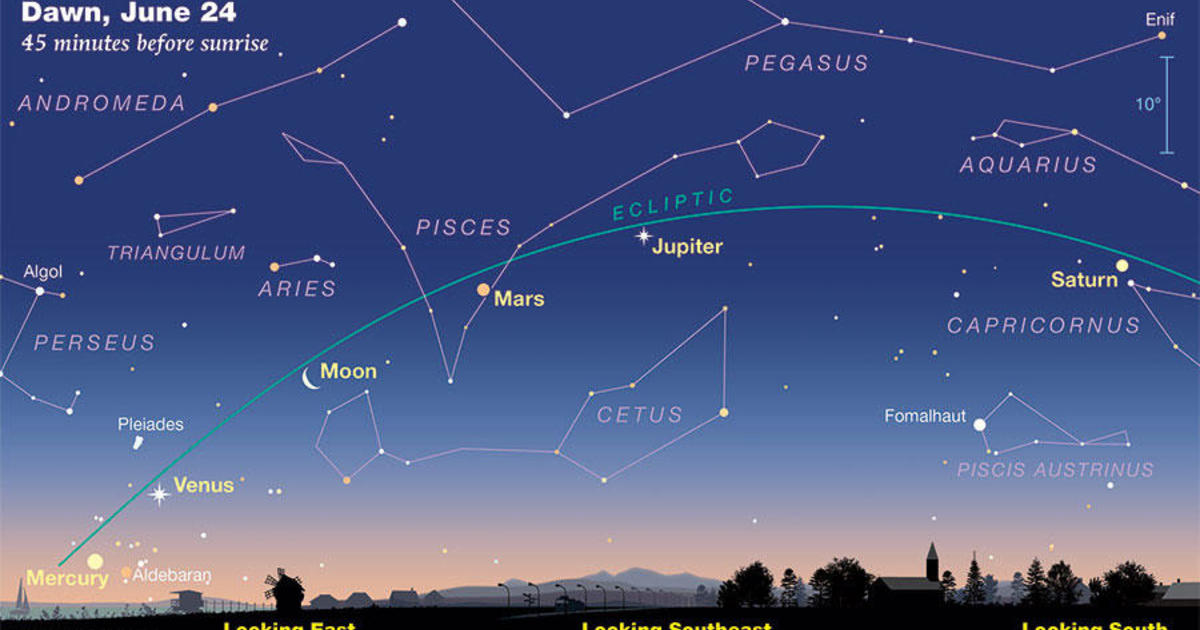

Fünf Planeten säumen im Juni den Himmel. So können Sie es sehen.

Fünf Planeten bewegen sich in einer seltenen Ausrichtung, die diese Woche von der Erde aus sichtbar sein wird. Merkur, Venus, Mars, Jupiter und...

Video. „Merry Christmas“, das Überraschungsduo von Elton John und Ed Sheeran, um Weihnachten...

Elton John und Ed Sheeran wünschen frohe Weihnachten in einem bunten Clip

...

ENTERTAINMENT

James Blunt enthüllt die wahre Bedeutung von ‚You’re Beautiful‘

Unterhaltung |

14. Februar 2022, 12:14 Uhr

Der britische Sänger James Blunt bestätigt die verdadero Significado von su éxito 'You're Beautiful' y aseguró que no...

Zwillinge heute, Horoskop für den 2. April 2022: Horoskopvorhersagen für Gesundheit, Liebe und Geld...

Wettervorhersage für Samstag, 2. April 2022Horoskop Karte Zwillinge: Arbeit und Geschäft: Sie werden sehen, dass die Ziele aufgrund unerwarteter Ereignisse geändert...

Benutzer haben berichtet, dass Azteken im Trailer zum Film „Thor: Love and Thunder“ erschienen...

Benutzer haben berichtet, dass die Azteken im Trailer zu „Thor: Love and Thunder“ erschienen sindAm 23. Juni wurde es von Los Angeles aus durchgeführt...

Die Dame mit dem Einhorn wird demnächst im Schlachthofmuseum zu sehen sein

Es ist ein vorübergehendes Exil, das von den Notwendigkeiten geleitet wird, die Sie kennen werden Die Dame und das Einhorn nächsten...

SCIENCE

Zu Beginn des Frühlings machen Ärzte auf den „Margarita-Ausschlag“ aufmerksam, der...

Während der Frühling naht, machen Dermatologen auf eine weniger bekannte Hauterkrankung aufmerksam, die mit Sonneneinstrahlung in Zusammenhang steht. Der Umgang mit bestimmten Lebensmitteln wie...

NEUESTE ARTIKEL

Latest article

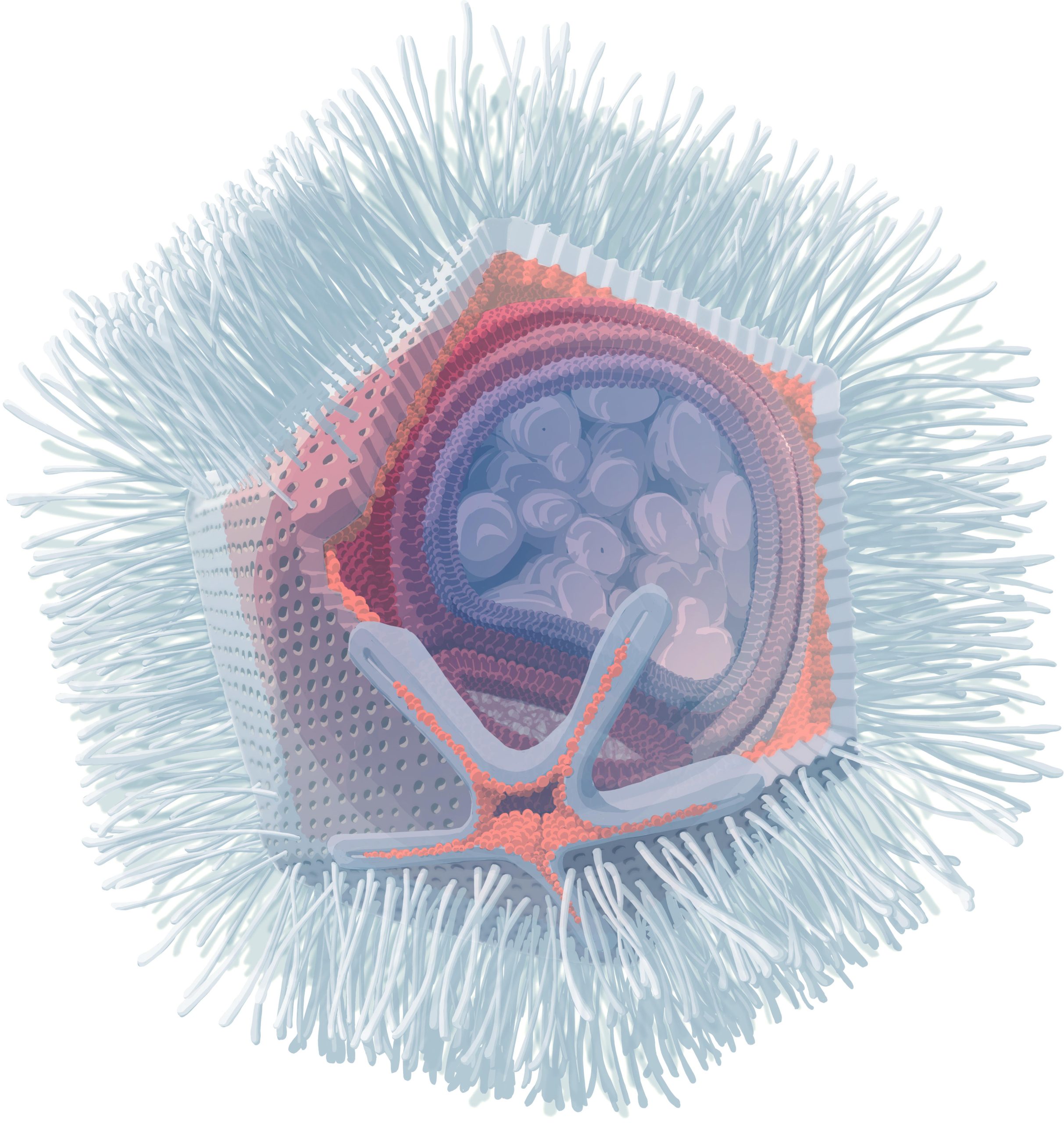

In den USA wurden vier weitere Katzen positiv auf die Vogelgrippe H5N1 getestet

Vier weitere Katzen seien im Zusammenhang mit einem zunehmenden Ausbruch bei Milchkühen in den Vereinigten Staaten positiv auf das Vogelgrippevirus H5N1 getestet worden, sagten...

Experten betrachten Trumps Prozess mit Argwohn

StartseitePolitikStand: 26. April 2024, 13:55 Uhraus: Fabian MüllerEr drücktTeiltDerzeit laufen in den USA mehrere Prozesse gegen Donald Trump. Anwälte gehen davon aus, dass...

:quality(75)/cloudfront-us-east-1.images.arcpublishing.com/elcomercio/WYNDQ3D2UJBEFPXTVSDSVHZZK4.jpg)

:quality(85)//cloudfront-us-east-1.images.arcpublishing.com/infobae/3R73NVULNFBFPJNWCSRH44DT4Y.jpeg)