Hochrechnung

In der Champions League Dictok | UEFA Champions League

Die UEFA Champions League hat heute ihren offiziellen Diktokonto veröffentlicht, um Millionen...

Tech

Gran Turismo 7: Amazon US liefert das Spiel vor einer Woche aus

Obwohl die Always-On-Anforderung des Spiels bedeutet, dass ein großer Teil des Spiels geschlossen bleibt, bis die Server nächste Woche hochgefahren sind, gelang es einigen...

Google verwandelt Pixel 6 in einen Autoschlüssel

Es wird möglich sein, ein Android-Smartphone als Autoschlüssel zu verwenden, die Tür zu öffnen und zu verriegeln sowie das Auto zu starten. Google...

Android 13 kann das Kopieren und Einfügen dank der neuen Zwischenablage vereinfachen

Google hat vor wenigen Tagen Android 13 Developer Preview 2 veröffentlicht. Die neue Version von Android 13 bietet eine Reihe von Funktionen wie...

ECONOMY

Britischen Fastfood-Restaurants gingen die Hühnchen aus und Geschäfte geschlossen – rts.ch

Einige britische Fastfood-Ketten haben wenig Hühnchen und Geschäfte müssen schließen: Thementhema: Arbeitskräftemangel in der gesamten Lieferkette, als Folge von Covid-19 aber auch als Folge...

Les vols affaires La Compagnie vers Paris et Milan sont sellés

vLa Saint Valentin ist nicht für die Liebe ? Amateurs d'offres de billets d'avion, oui (du moins...

Remote-Arbeit: diejenigen Mitarbeiter, die nicht mehr ins Büro zurückkehren wollen

Das neue Gesundheitsprotokoll in Unternehmen tritt am Mittwoch, 30. Juni, in Kraft, was die vierte Phase des Abbaus markiert. In Bezug auf die...

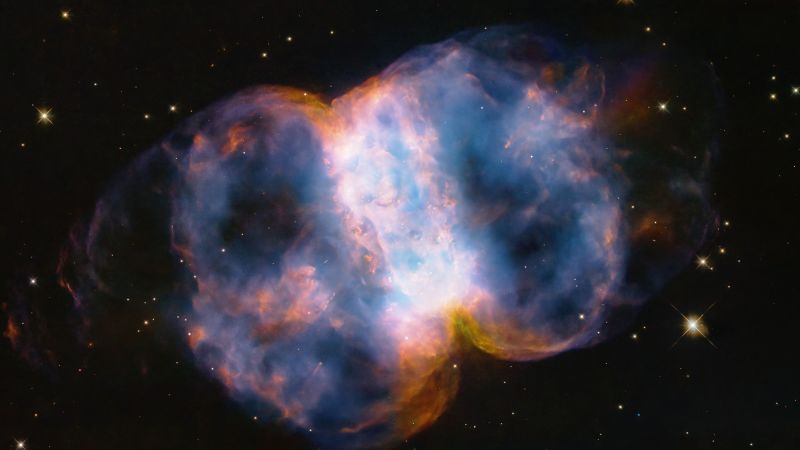

Die von chinesischen Wissenschaftlern entwickelte neue Karte der Milchstraße stellt die Theorien zur kosmischen...

Die Ergebnisse „werden neue Einblicke in die Ausbreitungs- und Wechselwirkungsprozesse und den Ursprung der energiereichsten kosmischen Strahlung in unserer Galaxie geben“, sagte Kazumasa Kawata...

Im Juli gewährt die Kirche den vollständigen Ablass

Anlässlich des Internationalen Tages der Großeltern und älteren Menschen hat Papst Franziskus einen Sonderkanon für die katholische Kirche verabschiedet. Gläubige, die am 23....

Ein im See schwimmendes Mädchen aus Georgia wird von einem riesigen tollwütigen Biber angegriffen

Ein kleines Mädchen wurde von einem tollwütigen Biber gebissen, berichteten lokale Medien, als es in einem See im Nordosten Georgias schwamm.Kevin Baker, Feldleiter der...

ENTERTAINMENT

‚The Crown‘ und ‚The Mandalorian‘ führen die Emmys an

Veröffentlicht in: 13.07.2021 -...

Mit einer tief ausgeschnittenen Bluse zeigt Chiquis Rivera ihre Gesichtszüge, während sie Meeresfrüchte isst

Chikes Rivera.

Foto: Rodrigo Varela/Getty Images

Riviera zittert Erlauben Sie, Ihr Konto zu sehen Instagram Wie er eine tolle Zeit in Mazatlan, Sinaloa hatte, wo er...

Sylvie Teller verlässt Miss France: Delphine Weisbeezer enthüllt, wer sie ersetzen kann

Vorstellungsgespräch von Tele-FreizeitDelphine Weisbaser sprach über die Miss-France-Community und den Abgang von...

So sind die Hauptmitarbeiter von El Amor Cambia de Piel, Televisa und Univision Telenovela...

Susanna GonzalezUnd David Zepeda NS Sergio Sendel Sie sind ein Trio von Helden.Liebe verändert die Haut', die neue Telenovela von Televisa und Univision. Das...

Kris Jenner tauscht ihren unverkennbaren Pixie-Schnitt gegen eine schulterlange Bob-Frisur, E! Nachrichten aus...

das neueSie können jetzt Fox News-Artikel anhören!

Kris Jenner ließ die Fans am Dienstag zweimal hinschauen, als sie eine neue Frisur debütierte.

Die junge Kardashian-Jenner ließ...

SCIENCE

Sandra Bullocks Partnerin stirbt an Amyotropher Lateralsklerose und die Familie bittet...

Was ist über die Ursache der Amyotrophen Lateralsklerose bekannt?Cudkovitch: Wir wissen, dass 10 Prozent der Menschen mit ALS ein Gen entweder von der Mutter...

NEUESTE ARTIKEL

Latest article

Aktualitäts- und zentrale Tendenzverzerrungen hängen mit dem Arbeitsgedächtnis zusammen

Zusammenfassung: Der Aktualitätsbias im Arbeitsgedächtnis ist untrennbar mit dem zentralen Tendenzbias verbunden und bietet eine einheitliche Erklärung für diese weitreichenden kognitiven Phänomene. Die...