Hochrechnung

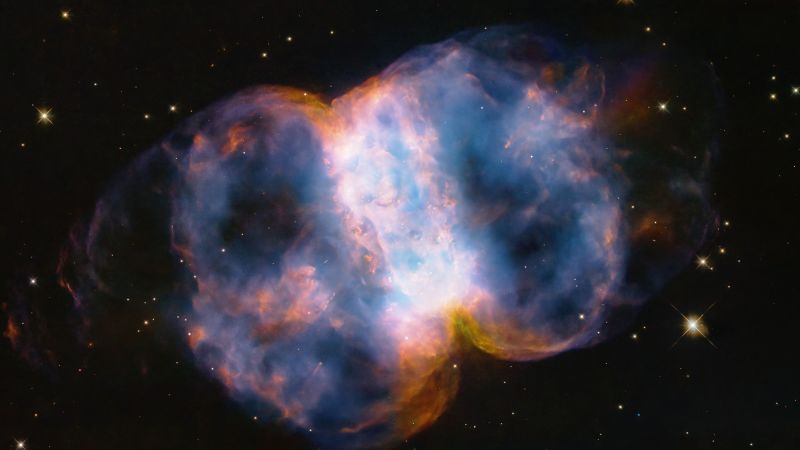

Rosa Diamanten in Australien: Geologen lösen das Rätsel

Warum verfärben sich so viele Diamanten aus der australischen Argyle-Mine rosa? Geologen aus Perth haben das untersucht und nun die Lösung gefunden. Sie...

Tech

So bewegt sich Ausdauer (fast) alleine auf dem Mars

Der Perseverance Rover rückt auf der Marsoberfläche vor und wird von der NASA genau überwacht. Allerdings überlässt die Agentur...

Sprach- und Videoanrufe über Facebook Messenger sind jetzt Ende-zu-Ende verschlüsselt

Instant-Messaging-Apps wie WhatsApp sind weit verbreitet, und für Sprach- und Videoanrufe im Messenger wird jetzt eine Ende-zu-Ende-Verschlüsselung verfügbar sein. Dies wurde am Freitag,...

One UI 4 (Android 12) ist ab sofort für das Samsung Galaxy S10 und S20 FE erhältlich

Quelle: Joe Maring / Android Central

Anfang dieser Woche hat Samsung die Einführung der stabilen One UI 4 auf die besten Android-Handys wieder aufgenommen, nachdem...

ECONOMY

Le Dollar (USD) franchi la barre des 140 Dinar (DZD)

Comme prévu, le dinar algérien Continue sa chute sur le marché officiel et est de plus en plus faible devant les devises étrangères. ...

Spanien. Die Kantine verbreitet sich schnell für den „hässlichen“ Gegner.

digitales Millennium

Mexiko Stadt / 21.09.2021 21:10:56

...

China entfernt Didi wegen Datenmissbrauchs aus App-Stores

Die mobile App von Didi ist für neue Benutzer in Online-Shops nicht mehr...

Erzgebirge Aue vs. 1. FC Magdeburg – TV-Übertragung, Live-Übertragung und Aufstellung zum Testspiel

Für Erzgebirge Aue steht folgender Test an: Es kollidiert mit dem 1. FC Magdeburg. Das Ziel erklärt, wie das Testspiel übertragen wird.Vorbereitung geht...

Verwöhnen Sie sich mit seinem unglaublichen 500 PS Audi RS3 [Vidéo]

Foto: benzin.frIch träume davon, im Juli ein Auto zu kaufen, es ist endlich möglich! Fans von Rapper Marseillais können die Gelegenheit nutzen. ...

Barcelona | Barcelona – Malaise: Überraschende Warnung des Dienstes an Memphis Depay!

Fußball - Barcelona

...

ENTERTAINMENT

Die vorgeschlagene Kombination aus TF1 und M6 gilt laut CSA als „natürlich“ und „konzeptionell“.

Veröffentlicht in: 07.09.2021 -...

Alfredo Adam bestätigt, dass er Laura Bozzo vor SAT . verraten hat

Mexiko: In einem kürzlich geführten Interview hat der Schauspieler Alfredo Adam Er bestätigte, dass er dem Steuerverwaltungssystem (SAT) den Verkauf der reservierten Immobilie mitgeteilt...

‚No Panties‘-Video: Chantal Joyas Überraschungsschimpf in der Kiste der Geheimnisse

Freitag, 17. Dezember in geheime TruheChantal Joya hat eine Barbie-Puppe mitgebracht. ...

Tageshoroskop: Was sagt mein Sternzeichen heute, Samstag, 5. Februar, mit Ihrem Sternzeichen | ...

Wollen Sie wissen, was die Sterne für Sie bereithalten? Heute ist Samstag, der 5. Februar? Der erfolgreiche Astrologe Jhan Sandoval bietet Ihnen Ihrer...

Manga-Anführer Takao Saito gestorben – freigelassen

VerschwindenDieser Artikel ist Abonnenten vorbehaltenMangaca, Mitbegründer des Atelier du Gekiga, ist am Freitag im Alter von 84 Jahren gestorben. Als Verfechter der kollektiven...

SCIENCE

St. Louis County sagt, tragen Sie Masken und lassen Sie sich...

Straße. Lewis County, Missouri – Die Behörden von St. Louis County haben andere Leitlinien für die öffentliche Gesundheit zu COVID-19 herausgegeben, in denen...

NEUESTE ARTIKEL

Latest article

Experten betrachten Trumps Prozess mit Argwohn

StartseitePolitikStand: 26. April 2024, 13:55 Uhraus: Fabian MüllerEr drücktTeiltDerzeit laufen in den USA mehrere Prozesse gegen Donald Trump. Anwälte gehen davon aus, dass...

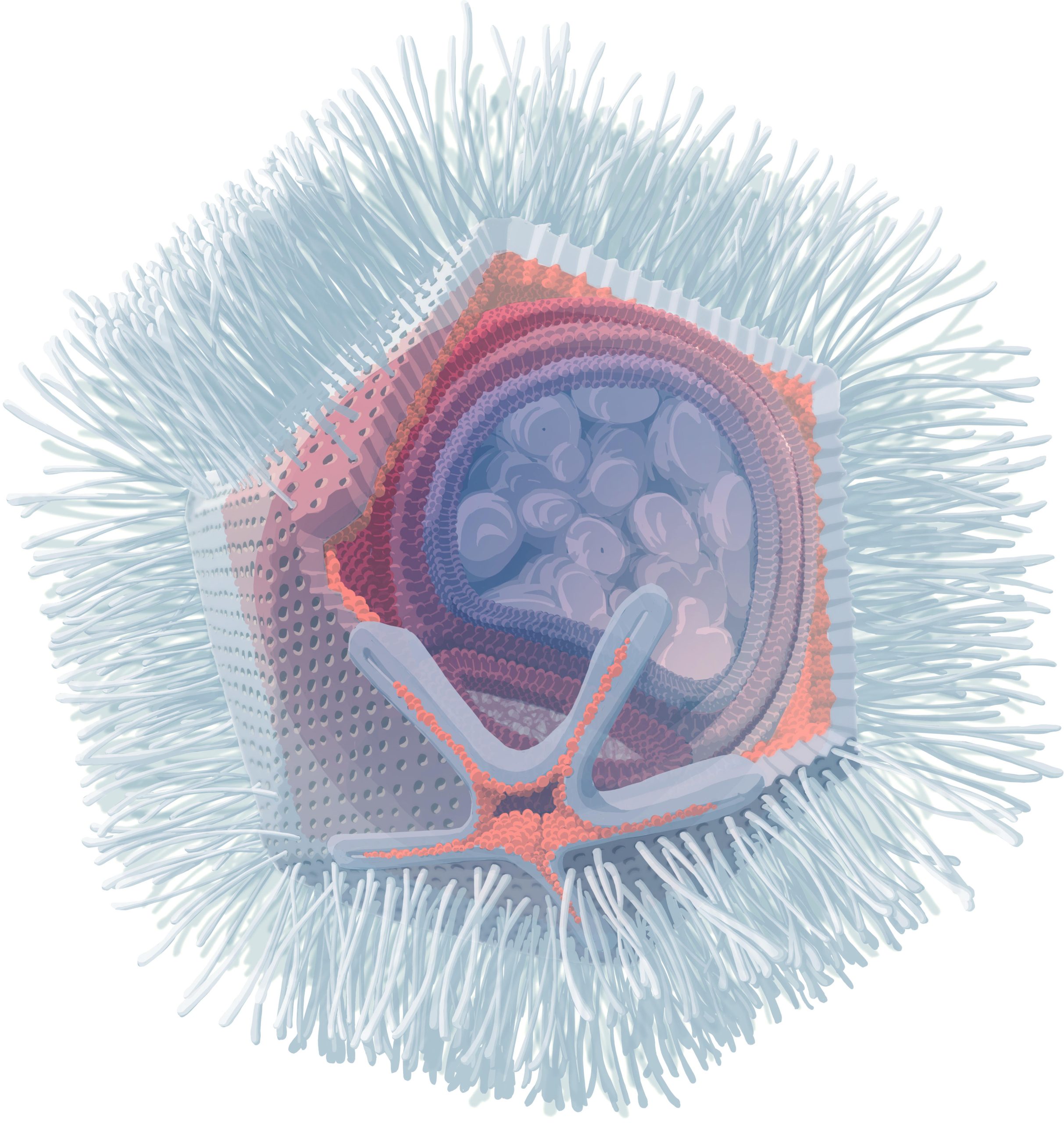

Ungewöhnliches Riesenvirus in Österreich entdeckt

Forscher der Universität Wien haben Viren namens Naegleriavirus entdeckt, die das gefährliche Bakterium Naegleria fowleri infizieren und neue Einblicke in die Virusbiologie und mögliche...

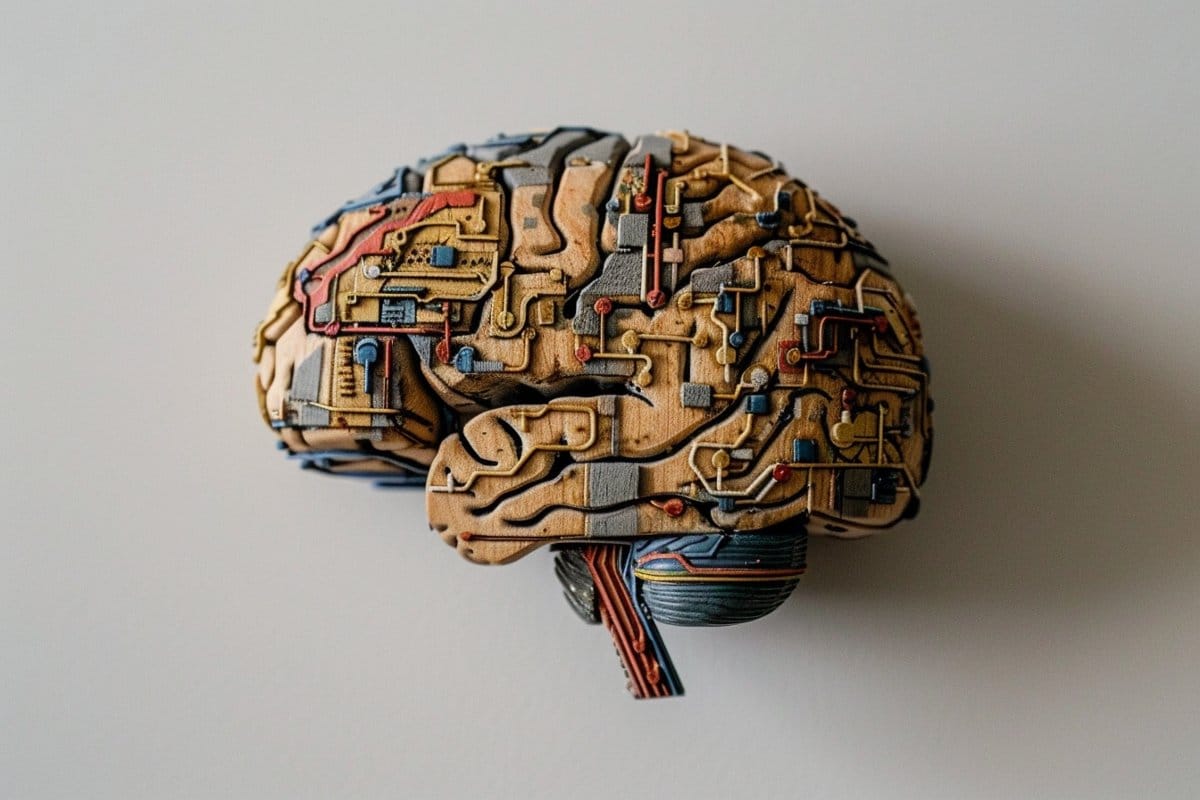

Aktualitäts- und zentrale Tendenzverzerrungen hängen mit dem Arbeitsgedächtnis zusammen

Zusammenfassung: Der Aktualitätsbias im Arbeitsgedächtnis ist untrennbar mit dem zentralen Tendenzbias verbunden und bietet eine einheitliche Erklärung für diese weitreichenden kognitiven Phänomene. Die...