Hochrechnung

Alan Finkelkraut über Putin: „Ukraine ist ein Name, den das imperiale...

aevlppe Zllueleulvullnua eu pel ehlnetteu Pllnelluu. Ble Zelu kepe pep uelhteluelle Bnppteup oluuelell, velt ple plp eu pelue...

Tech

konvertiert. Großes Nintendo-Wochenende mit Samus und OLED

Diese Woche wird zweifellos die wichtigste Woche für Nintendo für 2021 sein. Symbolisch zumindest. Denn am kommenden Freitag, 8. Oktober 2021, erscheint das...

Jabra Elite 75T Kopfhörer für unter 100 Euro im Darti

Nur für ein paar Tage bringt Darty Ihnen die Jabra Elite 75T Kopfhörer mit einem außergewöhnlichen Rabatt von -33 %! Damit befinden sie...

Was ist der beste Weg, um Geminiden heute Abend im Auge zu behalten?

Zwillinge sollten heute Nacht am Himmel auffallen. Dieser Sternenregen ist einer der schönsten Regenfälle des Jahres.

Zwillinge sind die letzten Sternschnuppen, die man in...

ECONOMY

Der Internationale Währungsfonds forderte die Zentralbank von Uruguay auf, die Geldpolitik zu straffen

Der Antrag wurde von der multilateralen Organisation zum Abschluss der Mission formuliert, die das Nachbarland in der vergangenen Woche besuchte.Der Internationale Währungsfonds sagte, eine...

Die Goldpreise fallen, da die Anleger eine mögliche Reaktion der Fed auf die NNDC-Inflation beurteilen | Wirtschaft

Lima, 15. November 2021Aktualisiert am 15.11.2021 um 08:42 UhrDie Goldpreise Sie fielen am Montag, als die Anleger die mögliche Reaktion der...

Reiche Briten werden ehrlich: Milliardäre finden Steueroasen zu langweilig

Reiche Briten sind an ihr Heimatland gebunden – so heißt...

Ist die Verwendung der Bitcoin-Anwendung sicher und welche Funktionen bietet diese App?

Kennen Sie Bitcoin? Es ist eine der beliebtesten Handelstechniken, die den Menschen das meiste Geld bringt. Die meisten Menschen erreichen mehr auf dem Markt...

CDC warnt Eltern und Kinderärzte vor den Gefahren des Enterovirus D68

Pittsburgh (KDKA) – Die CDC bittet Kinderärzte, nach Enterovirus D68 zu suchen, einer seltenen, aber schweren Atemwegsinfektion bei Kindern.„Dies ist eine sehr ernste Krankheit,...

Das iPhone 14 Pro soll eine große Neuheit bieten

Laut Analyst Ming-Chi Kuo steht Apple kurz davor, den Einsatz endlich zu erhöhen.

Seit dem iPhone 6s hat Apple die Auflösung der mit...

ENTERTAINMENT

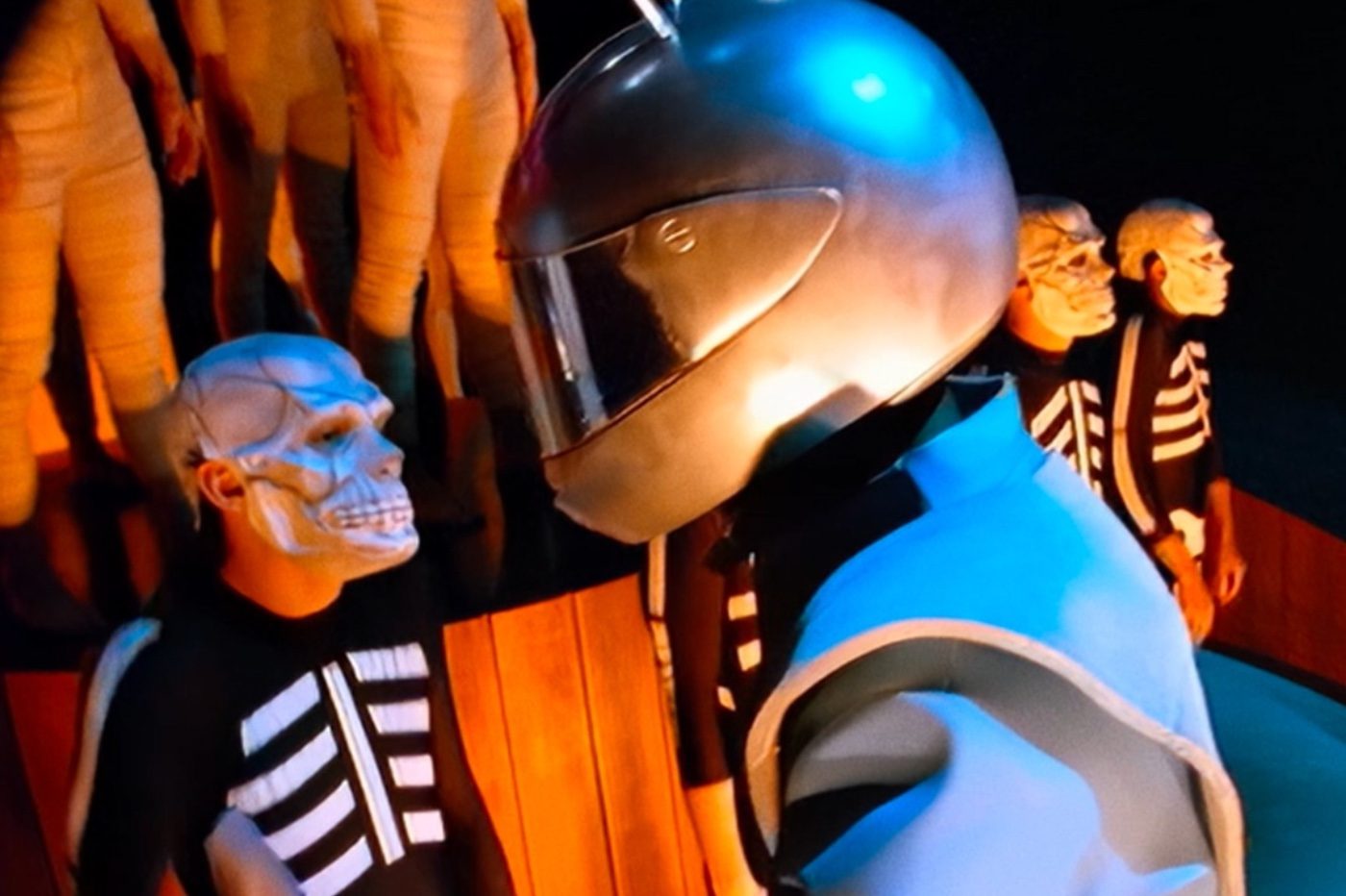

Daft Punk enthüllt neue Archive über den Clip auf der ganzen Welt

Daft Punk mag vor etwas mehr als einem Jahr das Ende seiner Karriere formalisiert haben, aber das hält das jetzt getrennte französische Duo nicht...

„Ich wollte stehlen“: Cyril Linnac enthüllt, dass zwei Nominierte für Konditor betrogen wurden

Der M6 startete am Donnerstag, den 23. Juni 2022, in die fünfte...

Cynthia Rodriguez, aus Venga la Alegría nach 17 Jahren … wenn auch nicht für...

Cynthia Rodriguez, Moderatorin von „Venga la Alegría“, verabschiedet sich nach 17 Jahren von der Morgenshow Mexikanisches Fernsehen Darüber...

Ich betrete CDMX Charlie and the Chocolate Factory

Direkt vom Broadway in Mexiko-Stadt angekommen, ist Charlie and the Chocolate Factory eine Musikshow mit 11 Schauspielern auf der Bühne, Live-Musik, dynamischer Choreografie und...

Großer Schreck! Polina Goto prangert schreckliche Erfahrungen mit einem Uber-Fahrer an

mexikanische schauspielerin Paulina Guto Er gab an, dass er einen sehr unangenehmen Moment hatte, als er ein Taxi vom Bahnsteig nahm ÜberDies liegt daran,...

SCIENCE

Der Erdkern scheint von einer uralten, mysteriösen Struktur bedeckt zu sein

Durch die Wissenschaft der seismischen Bildgebung haben Forscher herausgefunden, dass sich der alte Meeresboden möglicherweise um den Erdkern gewickelt hat. Die betreffende Schicht befindet...

NEUESTE ARTIKEL

Latest article

Diesmal gegen die Geschworenen im Prozess

StartseitePolitikStand: 24. April 2024, 19:25 Uhraus: Lisa SchmidmannEr drücktTeiltDonald Trump schreit erneut. Trotz der Mediensperre äußert sich der ehemalige US-Präsident im laufenden Prozess...

:quality(75)/cloudfront-us-east-1.images.arcpublishing.com/elcomercio/IDIFZBFGJRF27CNJT5FAYWG2U4.jpg)