Hochrechnung

Tech

Ein neues Rollenspiel-JRPG im Jahr 2023

Es ist gut, das zu sehen JRPGs beginnen die Xbox zu dominieren, von diesem Typ lange Zeit vernachlässigte Plattform! Nach einem starken Signal...

Es kommt in den USA an, aber in Frankreich müssen wir noch warten

Acht US-Bundesstaaten haben gerade angekündigt, dass sie in...

Elon Musk: Ein Affe, der mit einem Neuralink-Chip ausgestattet ist, der Pong spielt, indem er nachdenkt

Neuer großer Durchbruch für Elon Musk? Während der Milliardär seine Erfolge mit SpaceX oder Tesla fortsetzt, spricht ein anderes seiner Unternehmen, Neuralink, über...

ECONOMY

245 Sitze für Together!, 137 für Nupes und ihre Verbündeten, 89 für RN

Macron steht vor der...

Was ist ein VPN und wer braucht es?

VPN-Verbindungen sorgen für Sicherheit im Netzwerk. Hier ist, was Benutzer über VPNs wissen müssen.

Die...

Französische Meisterschaft: Rückkehr von Lyon-Charbonnier

Die legendäre 'Charbo', die dieses Jahr mangels Unterstützung durch die Stadt Lyon in Rallye Rhone-Charbonnier umbenannt wurde, ist nach zwei Jahren Unterbrechung wegen...

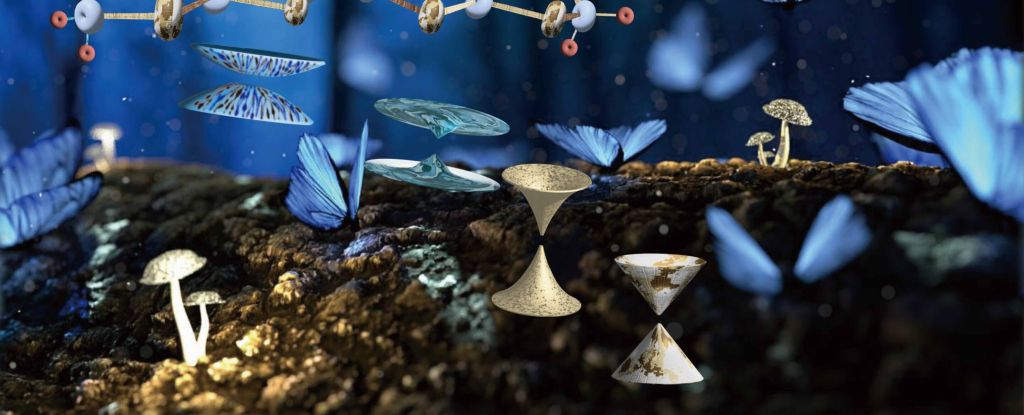

„Lichtgeschwindigkeit“-Elektronen, die sich in vier Dimensionen bewegen, erstmals entdeckt: ScienceAlert

Das schwer fassbare Verhalten von Elektronen konnte endlich von der gewöhnlichen Elektronenaktivität in einem realen Material isoliert werden.Ein Team von Physikern unter der Leitung...

Waked prangert die Verwendung eines seiner Songs in einem Clip zur Unterstützung von Eric...

Der Sänger kündigt eine Beschwerde an, nachdem er das Lied verwendet hat Eisen In einem Support-Video für Eric Zemmour, produziert von Génération Zemmour.Der Sänger...

ENTERTAINMENT

Video. Ein Beamter der Staatsanwaltschaft in Edomex weigert sich, eine Maske zu tragen;...

Foto: Auf Twitter hochgeladene Videoaufnahme

Die Staatsanwaltschaft nahm die ihr ausgehändigte Maske nicht an und ging ohne sie weiter

So verteidigte Eva Mendes den Barbie-Look von Ryan Gosling

Die Lifestyle-Unternehmerin, 48, die über ihre Schwammmarke sprach Rub-Stil In der Show fügte...

Erstes Foto des bahnbrechenden Films mit François Sevilla und Vincent Cassel

Die Neuverfilmung des berühmten Romans von Alexandre Dumas begann ihre gigantische Darstellung. Veröffentlichung für 2023 geplant.sich herausstellen Die drei Musketiere, eine sehr ambitionierte...

Lotto de la FDJ-Ergebnisse am Mittwoch, 13. Oktober 2021

Heute Abend, Mittwoch, 13. Oktober, findet die FDJ-Loto-Ziehung statt. Heute können Sie bis zu 8 Millionen Euro gewinnen, wenn Sie die richtigen 6...

SCIENCE

Gesundheitsbeamter des SLO County erlässt Impf- und Maskenpflicht

30. September 2023

Covid-Impfstoff (Bild/iStock)

Geschrieben von Karen Feeley

Der Gesundheitsbeamte des San Luis Obispo County hat am 21. September eine Impf- und Maskenverordnung erlassen,...

NEUESTE ARTIKEL

Latest article

Kamel im Wasser

StartseiteMeinungSäulenStand: 19. April 2024, 13:45 Uhraus: Manfred NikischEr drücktTeiltKamelreiten in der Wüste. © Imago/Bridgeman ImagesKünstlich Regen zu erzeugen ist eine Sache. Die...