Hochrechnung

Bac 2022: Hat Melon-Kandidat seinen Bachelor-Abschluss gewonnen?

Das ist eine der unwahrscheinlichsten Geschichten aus dem diesjährigen Bachelor: Der Student, der während der Philosophie eine Melone schnitt, hat seinen Bachelor bestanden!Er hat...

Tech

Das nächste kostenlose Spiel für 3D-Plattform-Fans

Jede Woche erlaubt sich der Epic-Onlineshop ein Spiel der Fantasie und des Wahnsinns: So können wir unsere persönliche Sammlung umsonst um neue Spiele erweitern....

Tintenfisch-Spiel: Verkehrsschilder beunruhigen Autofahrer

Das eskalierende Squid-Spiel jagt die Realität. Angesichts der Fragen von Autofahrern zu Straßenschildern veröffentlichte die britische Polizei im Thames Valley am Montag einen...

Instagram führt eine neue Timeline-Ansicht ein (will aber nicht wirklich, dass Sie sie verwenden)

Die amerikanische Plattform führt neue Optionen zum Anzeigen von Inhalten ein. Aber es erzwingt weiterhin die algorithmische Sortierung.Auf Instagram markiert der 23. März...

ECONOMY

Heineken veröffentlicht den Impfstoff und provoziert Ärger

Die Hersteller des beliebten Heineken-Biers sind in Aufruhr,...

Google Pay: Sparen, bezahlen und verwalten

Google Pay ist eine sichere, einfache und nützliche Methode zur Verwaltung Ihres Geldes und gibt Ihnen ein klareres Bild Ihrer Ausgaben und Ersparnisse:- Bezahlen...

Die Geschäftsbedingungen von Tesla entfernen es aus dem S&P ESG-Index

Der Indexanbieter führte auch Bedenken hinsichtlich der Arbeitsbedingungen und des Umgangs des Unternehmens...

Die Federal Reserve bewertet die Auswirkungen der Delta-Variablen von COVID auf die US-Wirtschaft

Er wiederholte, dass er vermeiden wolle, „vorübergehender“ Inflation hinterherzujagen und dabei möglicherweise das...

Dieselgate: Fiat Chrysler angeklagt, Autofahrerentschädigung wird möglich

Nach Volkswagen, Renault, Peugeot und Citroen steht auch Fiat Chrysler im Fadenkreuz der Justiz. Der Autokonzern wurde am Dienstag angeklagt wegen "Täuschung über...

Wissenschaftler warnen davor, dass ein gängiger Lebensmittelfarbstoff entzündliche Darmerkrankungen verursachen kann

Forscher sagen, dass der langfristige Verzehr von Allurarot-Lebensmittelfarbe eine mögliche Ursache für entzündliche Darmerkrankungen (IBDs), Morbus Crohn und Colitis ulcerosa sein könnte. Dieser...

ENTERTAINMENT

Paquita La Del Barrio weinte fast, um zu erklären, warum sie im Rollstuhl saß

Paquita la del Barrio trat bei den 14. Latin Grammy Awards auf

Foto: Robyn Beck/AFP/Getty Images

In einem Interview mit Univision "Primer Impacto", Paqueta La...

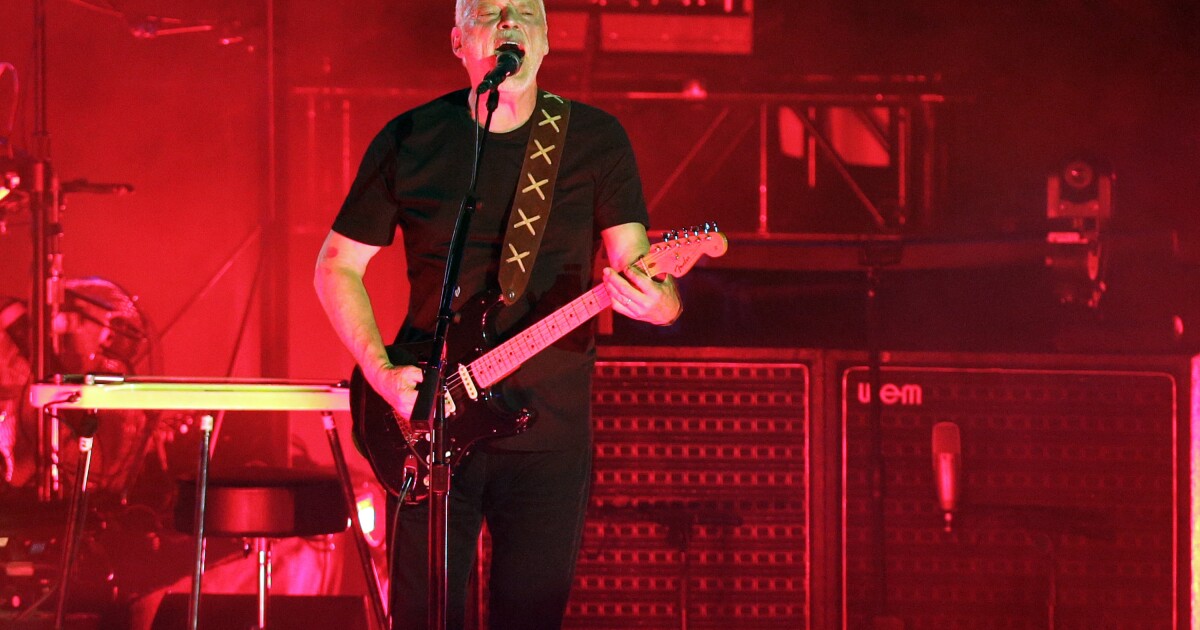

Pink Floyd reunitieren für ukrainischen Utility-Song

London - Pink Floyd veröffentlicht zum ersten Mal seit fast drei Jahrzehnten wieder neue Musik, um Geld für die Menschen in der Ukraine zu...

The Ugly No Conpetitor Die chinesische Version von I’m My Ugly Home | ...

Aktualisiert am 08.08.2021 21:40 UhrDie kolumbianische Serie, die mit ihrer lustigen und berührenden Geschichte die ganze Welt süchtig machte, ist "Ich bin mein hässliches...

„Sie ist eine Schlampe“: Javier Sirian kritisierte Ninel Conde in Larry Ramos ‚Fall und...

Javier Siriani erwähnte das auch Larry Ramos bezahlte ein Abendessen für Gustavo Adolfo Infante Wer hätte zugestimmt, "mit Ninel zu spielen"? Wasche Larrys BildDer...

SCIENCE

Die positiven COVID-19-Raten in Iowa sinken weiter

Und 13 Dollar pro Gallone aus dem letzten Monat. Eric: Die Allergiesaison ist eine schlechte Nachricht für Allergiker. Es kann schwierig sein,...

NEUESTE ARTIKEL

Latest article

Ein bahnbrechendes neues Prinzip – Koreanische Forscher haben ein revolutionäres Phänomen bei Flüssigkristallen entdeckt

Forscher haben herausgefunden, dass Objekte innerhalb eines Flüssigkristalls eine gerichtete Bewegung erreichen können, indem sie ihre Größe periodisch ändern, was den Weg für Fortschritte...

Die Abholzung der Wälder treibt Tiere im Wald Ugandas dazu, virusbeladenen Fledermauskot zu fressen

Geschrieben von Wedaile Chibiloshi und Natasha BottiBBC Newsvor 3 StundenBildquelle, Getty ImagesKommentieren Sie das Foto, Zu den Lebewesen, die beim Verzehr von Fledermauskot gefunden...

:quality(75)/cloudfront-us-east-1.images.arcpublishing.com/elcomercio/VS4JUAJHQFBIXHH6RXSLCKTS3E.jpg)

:quality(85)//cloudfront-us-east-1.images.arcpublishing.com/infobae/PSVUP5J55JEPTAPWXV2IMXXR4U.jpg)