Hochrechnung

Tech

Dolby Vision und Atmos seit zwei Jahren exklusiv bei Xbox

Die Technologie verbessert unser Spielerlebnis weiter ... Ob HDR, Quick Resume oder FPS Boost - neue Konsolen verändern unsere Spielebibliothek. Aufgrund der Partnerschaft...

Battlefield 2042: Entwickler beschäftigen sich mit einem verheerenden Fehler

Kevin Johnson, der Community-Manager, der an Battlefield 2042 arbeitet, reagierte auf einen der verheerendsten Pannen des Spiels, der es einigen Spielern ermöglicht, völlig unsichtbar...

Halo Infinite: Battle Pass ist nicht an XP gebunden

Die Spieler müssen unzählige tägliche Herausforderungen meistern, um den Battle Pass zu meistern.

Das Erscheinungsdatum von Halo Infinite, einem der am meisten erwarteten Spiele des...

ECONOMY

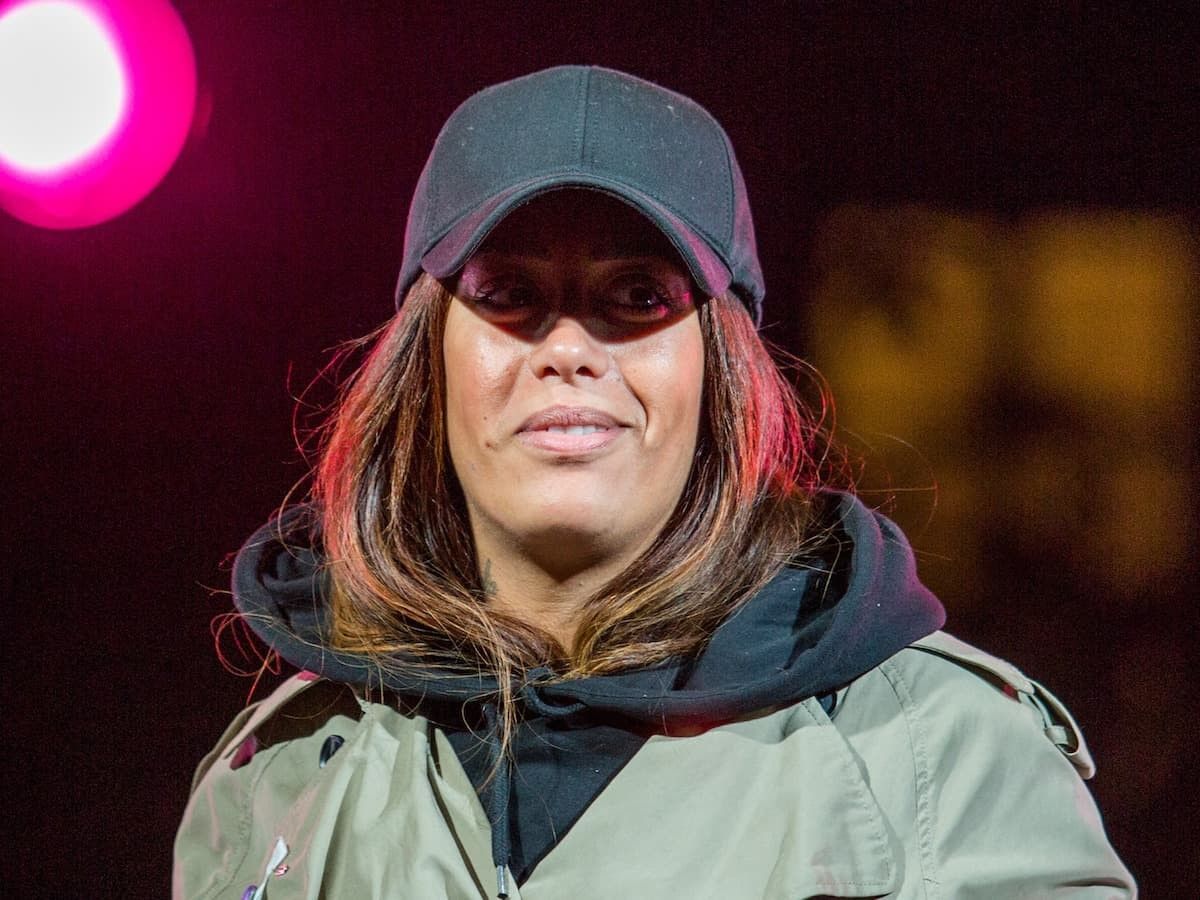

Amel Bent sogar „Geld“, Florent Bogney „sehr Strategie“? Die Talente von „The Voice“...

Bei der Veranstaltung, an der Sie teilnehmen Stimme, Und die vier Trainer kehrten zurück, fasziniert von deiner Stimme, mit wem möchtest du zusammenarbeiten? ...

20 Minuten intensiver Sport am Tag wirken Wunder für Teenager

Täglich 20 Minuten lang intensiv Sport zu treiben, ist möglicherweise der beste Weg, dies zu tun Jugendliche zur Entwicklung und Aufrechterhaltung der kardiorespiratorischen Fitnessschlägt...

ENTERTAINMENT

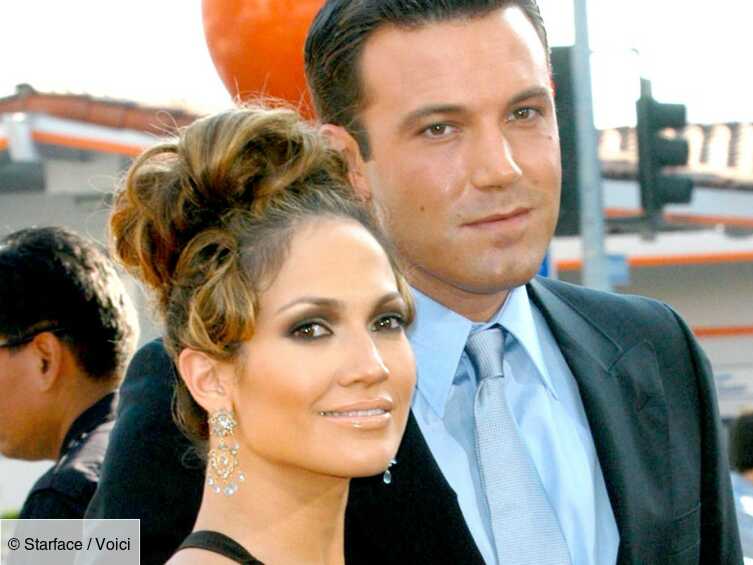

Fotos Jennifer Lopez und Ben Affleck als Paar: Finden Sie die Fotos ihrer Küsse...

Die Zukunft ist die Vergangenheit. Zumindest für Jennifer Lopez und Ben Affleck. Seite Sechs hat gerade Fotos von einem feurigen Kuss zwischen...

„Le Club des Invincibles“: Wer sind die Helden und Gäste der Nacht? (Samstag,...

"Le Club des Invincibles" beginnt um 21:05 Uhr in Frankreich 2 und Frankreich.TV. Zum ersten...

Indonesischer Regisseur Edwin erhält Goldenen Leoparden in Locarno – rts.ch

Rückblicke sind nie besser, als wenn sie sogenannte junge Filmemacher ehren. Das Label wird oft denjenigen zugeschrieben, die Filme machen, ohne sich um...

Fernanda Castillo feiert 40 Jahre Eric Heiser mit großen Glückwünschen

"Danke, dass du mich jeden Tag daran erinnerst, dass das Leben eine wundervolle...

NÎMES Lisa Gerrard bringt zwanzig Jahre Gladiator in die Arenen

Gladiator Live in der Arena Nîmes, gezeigt in der Originalfassung und mit französischen Untertiteln (Foto Yannick Pons)Zum ersten Mal in Frankreich der Film der...

SCIENCE

So beobachten Sie den Geminiden-Meteorschauer

Diese Woche wird voraussichtlich der Höhepunkt des jährlichen Geminiden-Meteorschauers erreicht, der laut NASA „als einer der besten und zuverlässigsten jährlichen Meteorschauer gilt“.

Diese jährliche Veranstaltung...

NEUESTE ARTIKEL

Latest article

Ein bahnbrechendes neues Prinzip – Koreanische Forscher haben ein revolutionäres Phänomen bei Flüssigkristallen entdeckt

Forscher haben herausgefunden, dass Objekte innerhalb eines Flüssigkristalls eine gerichtete Bewegung erreichen können, indem sie ihre Größe periodisch ändern, was den Weg für Fortschritte...

Die Abholzung der Wälder treibt Tiere im Wald Ugandas dazu, virusbeladenen Fledermauskot zu fressen

Geschrieben von Wedaile Chibiloshi und Natasha BottiBBC Newsvor 3 StundenBildquelle, Getty ImagesKommentieren Sie das Foto, Zu den Lebewesen, die beim Verzehr von Fledermauskot gefunden...