Hochrechnung

Ukraine News: Putin hält nach Kämpfen in Russland eine Sitzung des...

Das russische Außenministerium wirft dem Westen vor, das letztjährige Getreideabkommen mit der Ukraine zu sabotieren. In einer Erklärung des Ministeriums heißt es, Moskau werde...

Tech

Knochengeschichten, Geheimnisse des menschlichen Skeletts in Frankreich 2

Gefährlich - In einer unveröffentlichten Ausgabe von "Die außergewöhnlichen Kräfte des menschlichen Körpers" konzentrieren sich Michelle Sims und Adriana Karembeu auf die Funktionsweise unseres...

Elyon – Panzer Warlord Class Gameplay: Der Kriegsherr

MMORPGs haben diese süße Sache: Wenn Sie das Genre nicht revolutionieren wollen, werden Sie sich nicht völlig verloren fühlen. Die Evidenz mit Elyon...

Mackie CR8-XBT: PC monitor speakers

Mackie CR8-XBT: PC-Monitorlautsprecher, perfekt für hochwertiges Musikhören

Mackie ist einer dieser professionellen Gerätehersteller, die sich in unsere Häuser wagen.

So finden Sie Mackie-Lautsprecher auf einer Konzertbühne,...

ECONOMY

Wiederernennung von Xavier Huillard als Group President

Xavier Huillard, seit 2010 Chairman und Group CEO, erhielt auf der Hauptversammlung 90,79 % der Stimmen für eine neue Amtszeit von vier Jahren.

...

Google wird bis zum 4. April auf Hybridarbeit umstellen

Le PDG von Google, Sundar Pichai (AP Photo/Jeff Chiu)

NachrichtenagenturWie können Sie sagen, dass wir irgendwie aus der Epidemie herausgekommen sind, ohne zu sagen, dass...

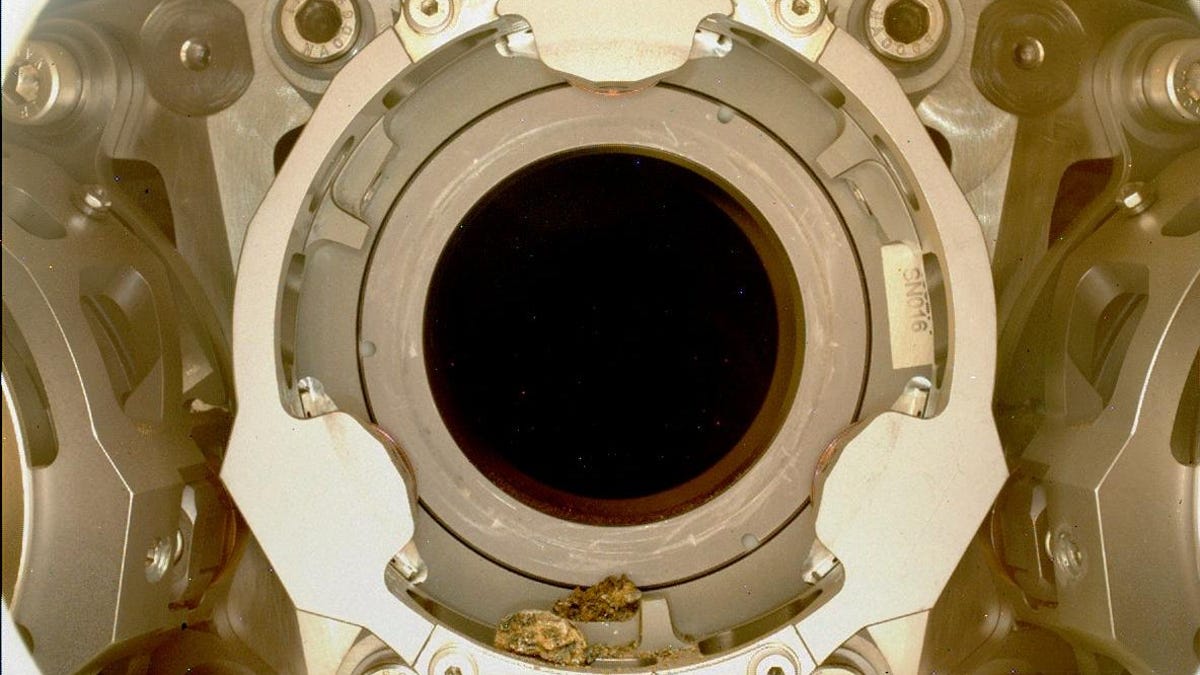

Perseverance Rover hat ein kleines Kieselsteinproblem

Der ausdauernde Rover hat ein Level erreicht Hindernis, nachdem die am 29. Dezember entnommene Gesteinsprobe vom Mars nicht ordnungsgemäß in den Speicher der...

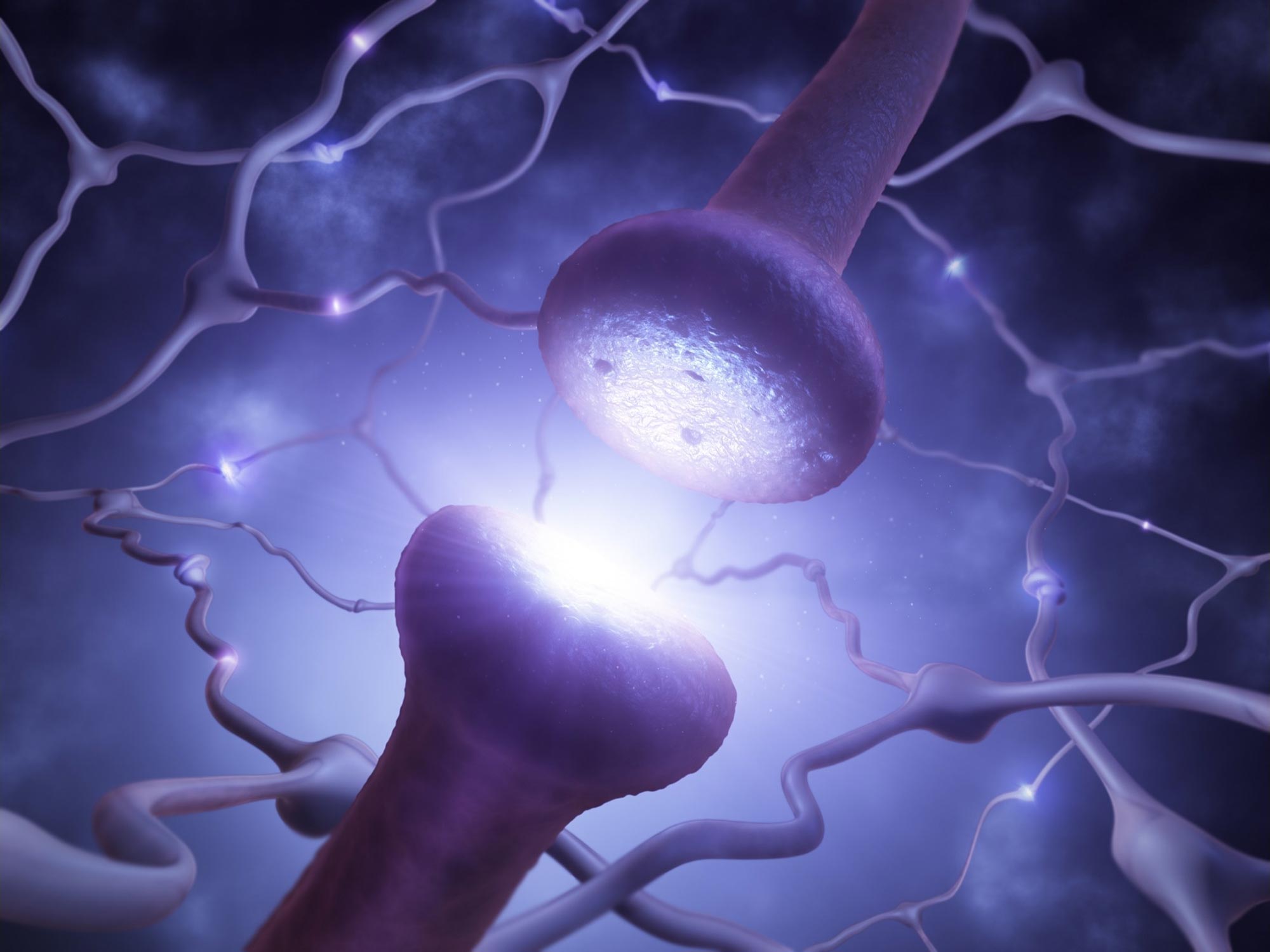

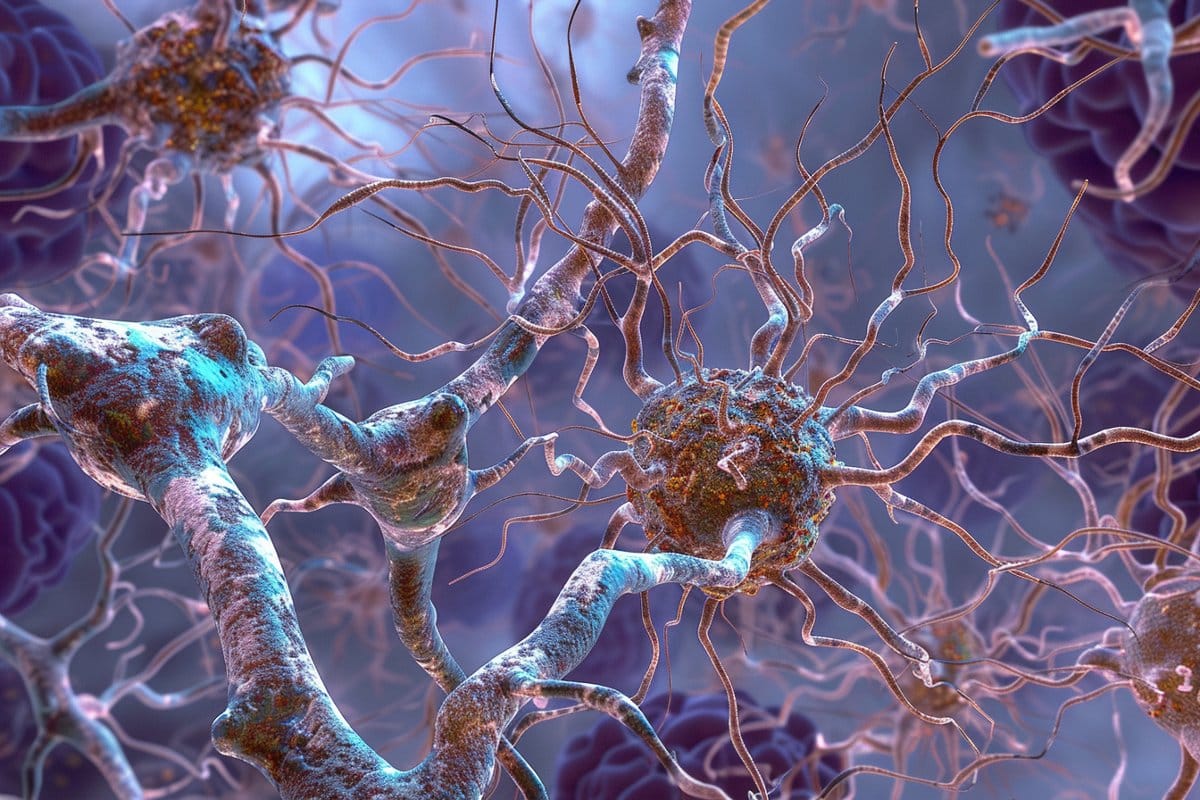

Wie funktioniert der innere Kompass des Gehirns?

Zusammenfassung: Die Ergebnisse werfen ein neues Licht darauf, wie sich das Gehirn in einer sich verändernden Umgebung orientiert und wie normale Navigationsprozesse als Folge...

ENTERTAINMENT

„Sogenannte…“: Olivier Veran vergisst den Namen seiner politischen Partei (ZAPTV)

Gast in einer Gruppe von Es liegt an dirAm...

Edwin Luna leitet Choreograf mit Trakalosa (Video)

Edwin Mun Der Choreograf nimmt mit Tracalose Um ein Video zu bekommen Tick TackTeilen Sie es auf seinen Social-Media-Konten.Im Video erscheint es Edwin Mun...

Fernsehfiction ist ein Diskussionsthema beim La Rochelle Festival – Foto

Während der 23. Ausgabe von La Rochelle Fiction, die am Sonntag endete, verliefen die Diskussionen gut. Im Zentrum der...

„Ein Interview, das viel Gesprächsstoff bringen wird“ Cyril Hanuns große Enthüllung auf Twitter!

Am Montag, 20. September 2021, beginnt für Cyril Hanoun und seine Autoren eine neue Woche. Ein Programm, das natürlich zu Ehren von Renee...

SCIENCE

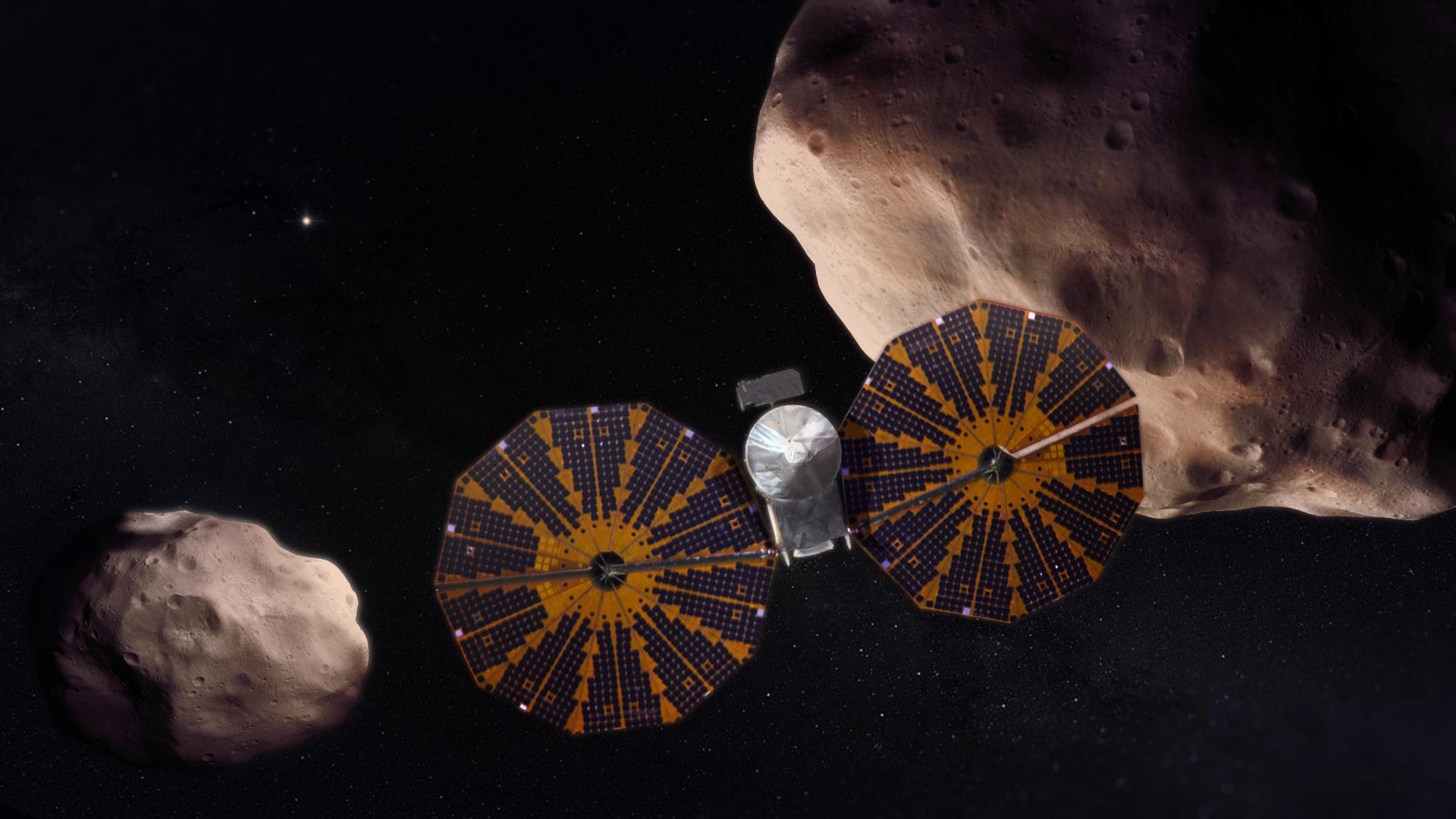

Der Mond wurde vom Lucy-Team der NASA um den Asteroiden Polymily...

Lucy wird Jupiters trojanische Asteroiden erforschen, von denen angenommen wird, dass sie „Fossilien der Planetenentstehung“ sind. Bildnachweis: Goddard Space Flight Center der NASAsogar...

NEUESTE ARTIKEL

Latest article

Diesmal gegen die Geschworenen im Prozess

StartseitePolitikStand: 24. April 2024, 19:25 Uhraus: Lisa SchmidmannEr drücktTeiltDonald Trump schreit erneut. Trotz der Mediensperre äußert sich der ehemalige US-Präsident im laufenden Prozess...

:quality(70):focal(128x98:138x108)/cloudfront-us-east-1.images.arcpublishing.com/sdpnoticias/SELONZ3SGBHAXLV2HTPCBTJJVY.png)