Hochrechnung

Ein Aufruf zur Unterstützung: Immer mehr illegale Grenzübertritte – Situation in...

Ausland Unterstützung anfordern Immer mehr illegale Grenzübertritte – die Situation in Litauen beunruhigt die Europäische Union ...

Tech

MotoGP 22, verfügbar am 21. April!

Das offizielle MotoGP-Spiel erscheint am 21. April mit vielen neuen Features, verfügbar für PlayStation 4, PlayStation 5, Xbox One und Xbox Series X |...

Alan Wakes American Nightmare verzögert seine Veröffentlichung in…

Alan Wake Vor kurzem kehrte er in einer überarbeiteten Version seiner frühen Abenteuer zurück, und sein Spin-off sollte 2012 den Xbox Game Pass auf...

Mobile App-Entwicklung: Tipps zur Erstellung einer effektiven App für Ihr Zielpublikum

Welches Unternehmen hat heutzutage nicht eine App? Egal, ob es sich um ein kleines Unternehmen oder ein großes Unternehmen handelt, die App-Entwicklung ist eine...

ECONOMY

US-Ökonomen ignorieren schwache Schaffung von Arbeitsplätzen

das Federal Reserve Laut Ökonomen ist die Wirtschaft auf dem besten Weg, die Zinsen im März...

Alfa wird eine Filiale von Axtel vorschlagen – El Financiero

Alfa wird eine außerordentliche Aktionärsversammlung abhalten, um seinen Aktionären die Abspaltung seines gesamten Beitrags zu Axtel vorzustellen.Er erklärte, dass er vorbehaltlich entsprechender Genehmigungen erwartet,...

Der Google Cloud-Programmierer berechnete pi bis zu 100 Milliarden Zahlen

Pi (π) ist eine große Zahl und daher kennen viele nur die ersten drei, also 3,14, hauptsächlich aufgrund des Mathematikunterrichts, wo die Zahl verwendet...

Das wundervolle Schauspiel von Konate in seiner Kindheitsgegend, um sein neues Hemd zu präsentieren

Der 22-jährige Ibrahim Konate, der während des Sommertransferfensters für 40 Millionen Euro zu Liverpool wechselte, enthüllte seine Trikotnummer auf die ursprüngliche Weise. Die...

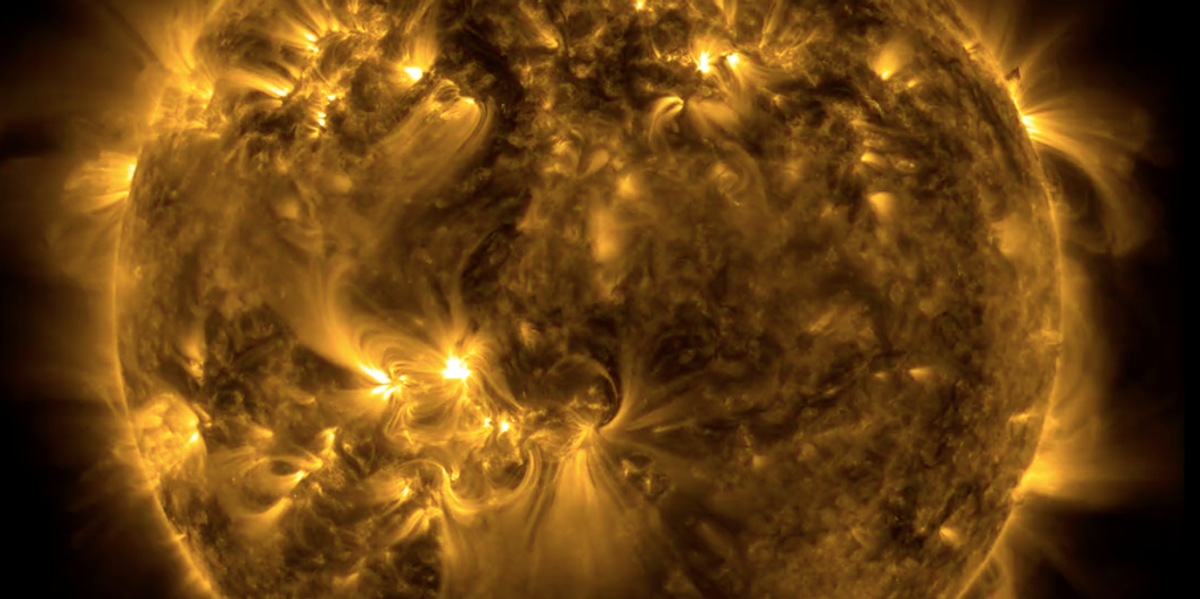

Auf der Sonne haben sich zwei riesige Schwarze Löcher geöffnet, die möglicherweise Winde mit...

In der Oberfläche der Sonne hat sich ein riesiges Loch geöffnet, das bald Sonnenwinde mit Millionen von Kilometern pro Stunde auf die Erde richten...

Führende Einzelpixeltechnologie ermöglicht die 3D-Bildgebung lebender Zellen

Wissenschaftler haben eine bahnbrechende 3D-Einzelpixel-Bildgebungstechnik (3D-SPI) entwickelt, die auf 3D-Lichtfeldbeleuchtung basiert. Diese Methode ermöglicht die hochauflösende Abbildung mikroskopischer Objekte. Der 3D-SPI-Ansatz könnte...

ENTERTAINMENT

Die mexikanische Sängerin Ana Gabriel enthüllt ihren Hollywood-Star mit Jessica Maldonado

Anna Gabriel enthüllte am Mittwoch ihren Stern auf dem Hollywood Walk of Fame und erfüllte damit ein Versprechen, das sie ihren Eltern vor Jahren...

Eine von Naomi Campbell gesponserte nigerianische Designerin debütierte auf der Paris Fashion Week

Die Pariser Modewoche Es öffnete seine Türen gestern mit einer nigerianischen Rezension Kenneth Easy Um die Frühjahrs- und Sommerkollektionen vor dem Publikum zu präsentieren,...

Instagram trennt sich bis Mitte März von der beliebten IGTV-App!

Es ist offiziell, das IGTV-Widget von Instagram wird Mitte März verschwinden. Die App will sich auf den Hauptservice konzentrieren.Zur Überraschung aller kündigt Instagram...

In Abwesenheit von TPMP spricht Kelly Vidovili auf Instagram

In den vergangenen Wochen fehlte Kelly Vidovili mehrfach Fass meinen Beitrag nicht anH. Das macht den Zuschauern Sorgen. Es kam jedoch immer...

Louis Bertignac verliebte sich beim Cabourg Festival in Zoe Adjani und Alice Blaydy

Cabourg ist die Outdoor-Plattform für die Starparade! Norman veranstaltet eine neue Ausgabe seines Filmfestivals. Louis Bertignac und seine Partnerin Letitia Brichet, Zoe...

SCIENCE

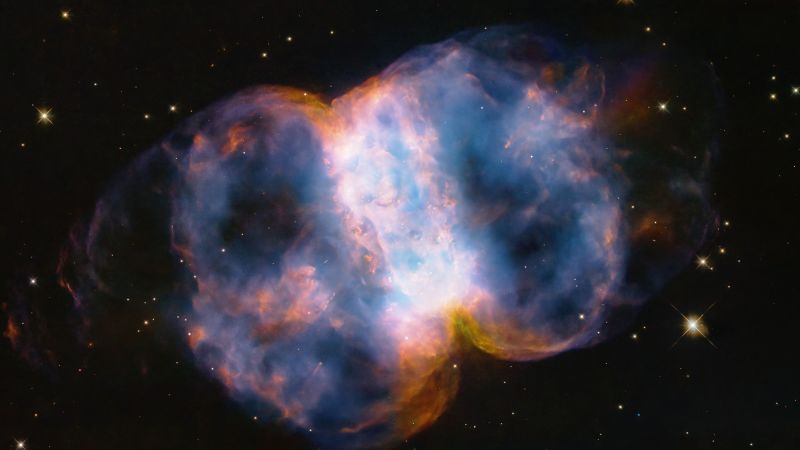

Die NASA möchte, dass Sie bei der Verfolgung von Gammastrahlenausbrüchen helfen

Möglicherweise können Sie der NASA dabei helfen, die Ursprünge der stärksten Explosionen im Universum aufzuspüren.Obwohl Astronomen seit den 1960er Jahren Gammastrahlenausbrüche entdecken, müssen sie...

NEUESTE ARTIKEL

Latest article

Aktualitäts- und zentrale Tendenzverzerrungen hängen mit dem Arbeitsgedächtnis zusammen

Zusammenfassung: Der Aktualitätsbias im Arbeitsgedächtnis ist untrennbar mit dem zentralen Tendenzbias verbunden und bietet eine einheitliche Erklärung für diese weitreichenden kognitiven Phänomene. Die...

/thumbs.vodgc.net/1-14-96S1uq1632811787528-1632812010.jpg)