Hochrechnung

Inter reagiert auf Milan und bleibt im Rennen um den Scudetto

Wenige Stunden nach dem Sieg von Milan, dem anderen lombardischen Verein im Rennen um den Meistertitel, besiegte Inter Mailand am 35. Spieltag der italienischen...

Tech

Online-Casino-Apps für iOS und Android

Gaming findet heute nicht nur am Computer zu Hause, sondern auch unterwegs statt. Statistiken sprechen für sich und die Online-Casino-Szene ist keine Ausnahme. Ein...

Guilty Gear Strive DLC Jack-O‘ 2nd Character Tricks & Deals später in diesem Monat

Guilty Gear Strive wird noch in diesem Monat einen zweiten Charakter-DLC erhalten. Der zurückkehrende Kämpfer Jack-O' befindet sich bereits im Story-Modus des Spiels,...

ECONOMY

Mexikos jährliche Inflation könnte in der ersten Oktoberhälfte wieder 6 % überschritten haben: Umfrage

Reuters. - Eine Reuters-Umfrage am Montag zeigte, dass die jährliche Inflationsrate...

Die Toilette verwandelt Abfall in virtuelle Energie und Geld

Es gibt ein beliebtes Video des Kinderprogramms 31 Minuten, in dem die Figur Juan Carlos Puduc erklärt "Stuhlweg“ und erklärt, wie menschliche Fäkalien einen...

Die Digital Currency Group verkauft Aktien im Wert von 700 Millionen US-Dollar an Investoren mit Gewinn

Digitale Währungsgruppe (DCG), Eines der größten Unternehmen im Kryptowährungssektor hat eine wichtige Sekundärinvestitionsrunde unter der Leitung des japanischen Finanzriesen abgeschlossen. SoftBank.

DCG verkaufte Aktien im...

After Damage: Russland stürzt eine Raumkapsel ab

Ein beschädigtes russisches Space Shuttle ist über dem Pazifischen Ozean abgestürzt. Zwei Astronauten warten noch immer auf ihre Rückkehr zur Erde auf der...

Motorrad: Ein Landsberger Schrotter Motorradfahrer startet mit gebrochener Hand

Plus

Trotz seines Handicaps will der Landsberger zum Saisonstart in Katar mit seinem Rad aus Memmingen an den Start gehen. ...

Surface Slim Pen 2 mit integrierter Haptik-Engine vorgestellt

Microsoft hat gerade einen neuen Eingabestift namens Surface Slim Pen 2 . vorgestelltDas zielt darauf ab, das Schreiben und Zeichnen realistischer zu machen. ...

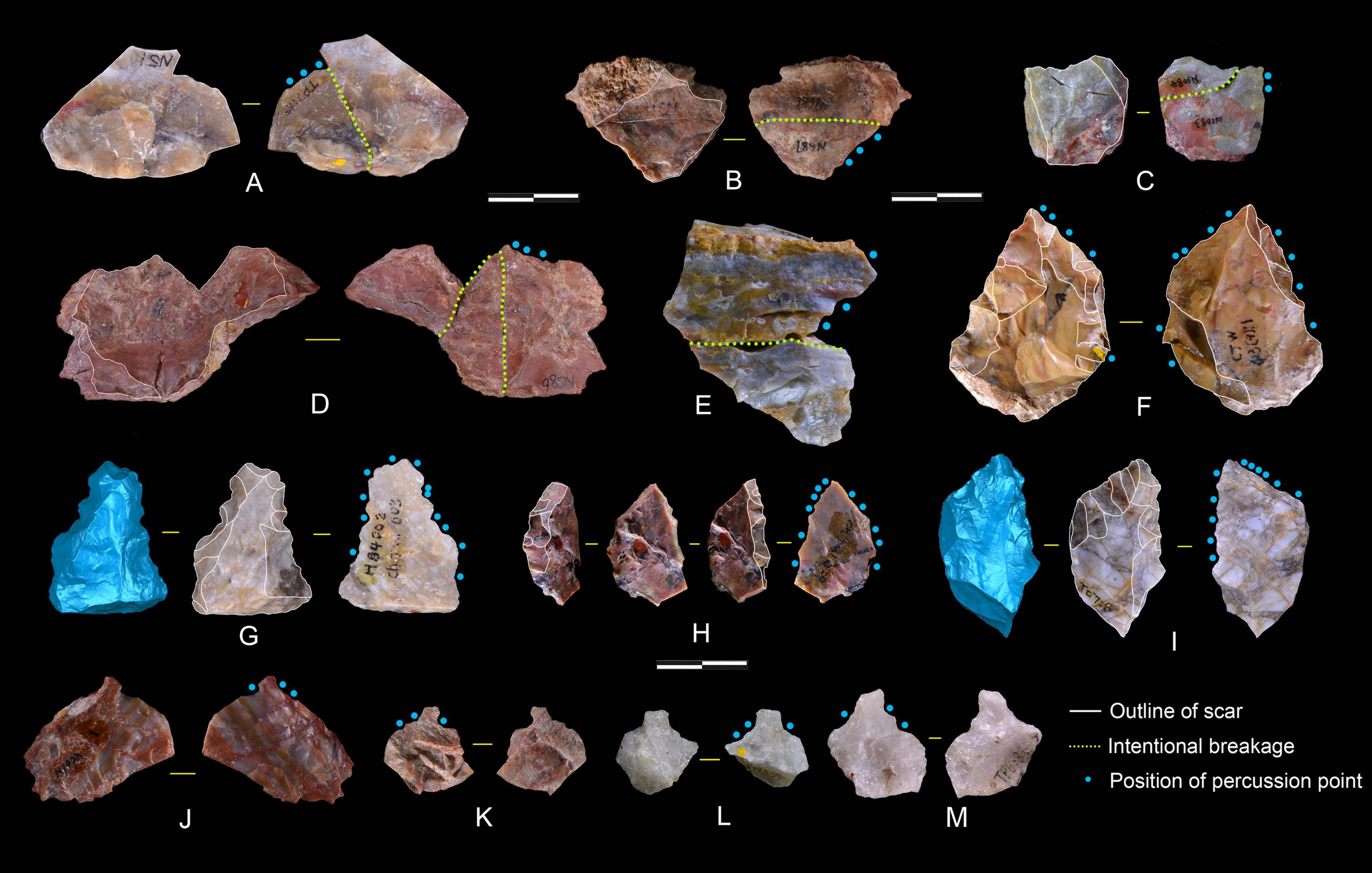

Wissenschaftler haben in China fortschrittliche Werkzeuge entdeckt, die 1,1 Millionen Jahre alt sind

Eine bahnbrechende Studie zeigt, dass Ostasien vor mehr als 1,1 Millionen Jahren von Homininen mit fortgeschrittenen Werkzeugherstellungsfähigkeiten bewohnt wurde, die der Modus-2-Technologie entsprachen, was...

ENTERTAINMENT

Französisches Filmfestival 2022, eine mit der Pandemie kompatible Kinoausstellung

Zwölfte Ausgabe von Französisches Filmfestival Es wird eine Ausstellung sein, die sich darauf konzentriert, dem mexikanischen Publikum die Vielfalt des französischen Kinos unabhängig von...

WWE WrestleMania 38: Zeitplan, wann und wo live zu sehen

Fast vier Jahrzehnte Geschichte. Die WWE Es erreichte 38 Ausgaben von WrestleManiaDie Veranstaltung gilt als...

Publikum: „Little Murders…“ auf dem Vormarsch, „Mask Singer“, der Anführer von FRDA, „Le grand...

France 2 stieg am Freitagabend mit der Rückkehr der dritten Staffel der Serie „Die kleinen Morde der Agatha Christie“ an die Spitze der Zuschauerzahlen....

Jade Lagardère vor Gericht: Das Modell versuchte, seinen Führerschein zu kaufen

Jade Lagardère wurde gerade vor dem Gericht in Pontoise angeklagt, als er beschuldigt wurde, seinen Führerschein gekauft zu haben. Das Modell bestreitet jede...

Stefan Plaza: Carol Carat Boost? Die muskulöse Faust des Gastgebers

Stéphane Plaza arbeitet demnächst mit Carol, der Schwester von Fabien Carat, für die er eine Wohnung in Paris gefunden hat. Rekrutierungsbooster für viele....

SCIENCE

In den letzten 24 Stunden wurden über 3.500 neue Fälle von...

Was sollte ich über eine Delta-Variable wissen?Es ist die bisher ansteckendste Coronavirus-Mutation in der Pandemie, aber COVID-19-Impfstoffe bieten immer noch einen wirksamen Schutz vor...

NEUESTE ARTIKEL

Latest article

Kamel im Wasser

StartseiteMeinungSäulenStand: 19. April 2024, 13:45 Uhraus: Manfred NikischEr drücktTeiltKamelreiten in der Wüste. © Imago/Bridgeman ImagesKünstlich Regen zu erzeugen ist eine Sache. Die...