Hochrechnung

Tech

Überraschung ! Nintendo stellt ein köstliches neues Kirby-Spiel vor

Nur wenige Monate nach Kirby and the Forgotten World kündigte Nintendo ein verlockendes neues Spiel an.

Kuchen, Obst und Sahne. Das alles erwartet Sie...

Christina Hack könnte eine weitere Verlobung bekannt geben, während Ex-Mann Tarek El Moussa zum Altar geht.

Tariq El Moussa ist Wochen (Tage?) von seiner Hochzeit mit seiner Verlobten Heather Ray Young entfernt, aber das hält Gerüchte nicht auf, dass seine...

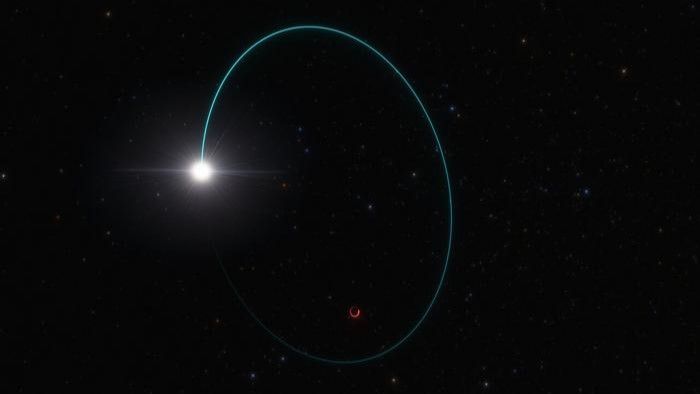

Wir erzählen Ihnen alles über die sichtbare totale Mondfinsternis von Sonntag bis Montag

Sie müssen den Wecker sehr früh stellen. Die Erde, der Mond und die Sonne haben ein Datum für totale Sonnenfinsternisse in der Nacht...

ECONOMY

Multinationale Unternehmen schließen Allianz zur Reduzierung der Luftverschmutzung

EFE

Genf / 03.11.2021 14:43:21

...

Auf Molotov wird der Zugang zu M6-Gruppenkanälen kostenpflichtig

Eine Woche nachdem er des "Parasitismus" für schuldig befunden wurde, einigte sich die Plattform mit M6. Auf Gruppenkanäle kann jetzt nur noch über...

Harte Zeiten Passende Taxis in Uber und New York | Meinung

Für Uber ist die Einlösung das beste Ziel, das man mit dem Taxi erreichen kann. VTC wird mit New Yorker Taxis zusammenarbeiten, um...

Ex-Weltmeister vorgestellt: Podolski unterschreibt Vertrag bei Gornik Zabrze

Der ehemalige Fußballweltmeister Lukas Podolski hat beim polnischen Spitzenklub Gornick Zabrze einen Einjahresvertrag unterschrieben.

"Ich freue mich, zu Hause zu sein und in diesem Stadion...

Lächeln, Moe York – Bearbeitung

Vorgestelltes AlbumDieser Artikel ist Abonnenten vorbehaltenDas Debütalbum des Radiohead-Trios „Light to Draw Attention“ offenbart keine große Neuerung, die ihm eine Identität verleihen könnte.Thom Yorke...

Russland wollte den Beitritt Schwedens zur NATO sabotieren

Um eine NATO-Erweiterung zu verhindern, hat Russland möglicherweise ungewöhnliche Maßnahmen ergriffen. Eine wichtige Rolle spielt dabei der türkische Präsident Erdogan. Russland plant möglicherweise,...

„Es macht ihn sehr glücklich“: Franுவாois Hardy interessiert sich für die Tour von Jack...

Die Konzerttournee von Thomas und Jack Dutrank beginnt diesen Dienstag, den 12. April. Eine besondere...

ENTERTAINMENT

Ein Bild von Marilyn Monroe von Andy Warhol wurde bei Christie’s auf 200 Millionen...

Sein „Shot Sage Blue Marilyn“, gemalt von Andy Warhol im Jahr 1964, ist laut einer Pressemitteilung von Christie’s „das wichtigste Gemälde des 20. Jahrhunderts,...

Nabila: Thomas the clashe lebt „Du hast schon 100 Kilo Prothesen“!

Es ist Satin in der Vergara-Familie! Die leere Umkleidekabine von Thomas...

Wer ist Solella Chow, die Tänzerin, die Alfan und Ahiz auf der Bühne begleitet?

Von unserem Sonderkorrespondenten in...

Marvel: Sie enthüllten einen angeblichen Blick auf Tenoch Huerta als „Namor“ in „Black Panther:...

Gerüchte über den Film Black Panther: Wakanda für immer Sie stehen immer noch unter starkem Schutz, aber an diesem Wochenende wurde bekannt, was der...

Horoskope: descubre qué te deparan los astros este miércoles 16 de febrero

Escrito en VIRALEN El 16.2.2022 07:00 Uhr Conoce lo que depara tu destino con los horóscopos de Erika Navi....

SCIENCE

Endgültige Pläne für einen fortgeschrittenen kosmischen Kartografen

Die SPHEREx-Mission wird einige Ähnlichkeiten mit habenhttps://www.youtube.com/watch?v=lr7lqm9KNMsDie NASA-Mission SPHEREx wird den gesamten Himmel in 97 Farbbändern scannen und eine Karte erstellen, von der Astronomen...

NEUESTE ARTIKEL

Latest article

Die Kennedy-Familie unterstützt Joe Biden, nicht Robert Kennedy Jr.

Robert Kennedy Jr. ist ein großer Name, der für das Präsidentenamt kandidiert. Die einflussreiche Familie möchte Joe Biden jedoch weiterhin im Weißen Haus...

schnell! Jemand besorgt sich dieses Arztbuch.

Nicht an jedem Arbeitsplatz gibt es eine Guillotine. Im Buchkonservierungslabor unter der ersten Etage des Metropolitan Museum of Art könnte die Büro-Guillotine ein...

:quality(70):focal(2845x1695:2855x1705)/cloudfront-eu-central-1.images.arcpublishing.com/liberation/NJA5AFUI6VGLJP2C44D6QM7SVU.jpg)