Hochrechnung

Tech

Huawei aktualisiert seine 16-Zoll-MateBook-Ultrabooks

Auf der Liste: eine Vorlage, die speziell für Kreative entwickelt wurde, und eine andere, die eher für die allgemeine Produktivität entwickelt wurde.

Heute stellt Huawei...

Cyberpunk 2077 verliert riesigen Content-Patch, kann den Namen ändern

Nach einer komplexen Veröffentlichung von Cyberpunk 2077 wird das Rollenspiel von CD Projekt RED viele große Überraschungen bringen.

Obwohl es sich um einen unbestreitbaren kommerziellen...

ECONOMY

Die Fed ist auf dem besten Weg, die Zinsen in den kommenden Monaten aggressiver anzuheben

Foto der Federal Reserve in Washington, USA (Reuters / Leah Millis)Tendenziell erhöht die US-Notenbank (Fed) die Zinsen aggressiver als bisherin Schritten von einem halben...

Was ist SPEI 2.0 und warum würde es der finanziellen Inklusion nützen?

Die Bank of Mexico entwickelt ihr elektronisches Interbanken-Zahlungssystem SPEI 2.0, das darauf zurückzuführen ist, dass die Zahl der Operationen in diesem Jahr um 52...

Wall Street endet scharf, beeinflusst von Technologie und Facebook

Veröffentlicht in: 10.04.2021 -...

Roberto Benigni hielt eine berührende Rede, nachdem er bei den Filmfestspielen von Venedig 2021...

Lima, 3. September 2021Aktualisiert am 09.03.2021 21:49Anders als es aus seiner Sicht des "Komikers" erscheinen mag, ist der Italiener Roberto Benigni Kino sei für...

Energiekrise: Gaspreise stiegen um bis zu 35 %

Geschäft Energiekrise Gaspreise um bis zu 35 % gestiegen Stand: 17:30 Uhr| Lesezeit: 3 Minuten...

ZDF-Ausrüstung bei Sturm auf das Kapitol zerstört – Mensch muss Schadensersatz zahlen

draußen Raten über 131 Jahre ZDF-Ausrüstung bei Sturm auf das Kapitol zerstört – Mensch muss Schadensersatz zahlen ...

Die Online-Wettseite entschuldigt sich bei der Familie Mbappe nach der Nachricht „schlechter Geschmack“.

Ein Online-Buchmacher hat sich bei Wilfried Mbappe und seiner Familie nach einem in den sozialen Medien geposteten „geschmacklosen“ Witz entschuldigt. Ende März hatte...

ENTERTAINMENT

Batman: Zeigt ein „Fledermaussignal“ auf Ihrem Bildschirm an; So aktivieren Sie bei Google

Eric Eduardo Saldana

Abfassung / 01.03.2022 16:57:35

...

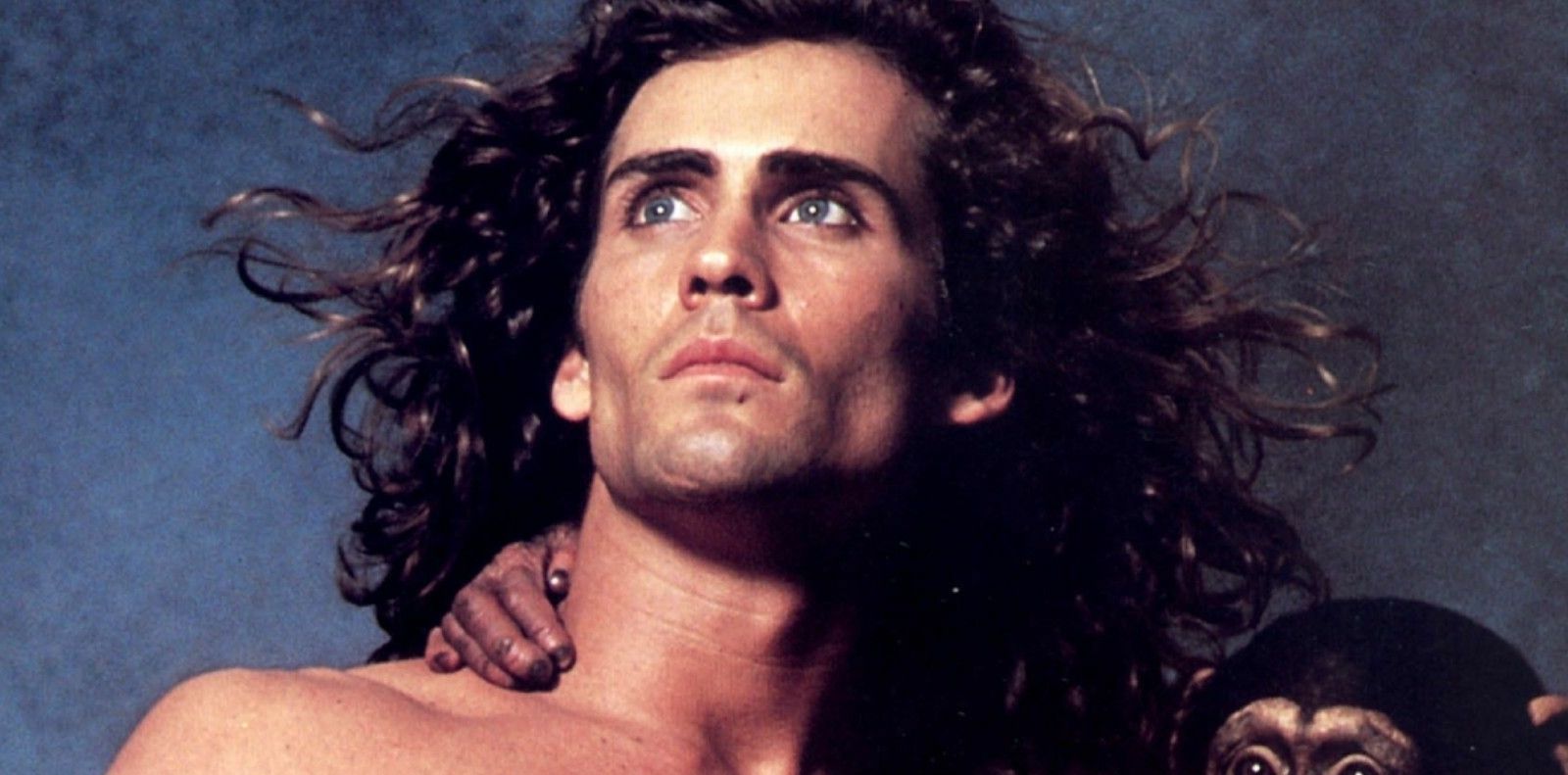

Joe Lara, Tarzan TV und großer Filmschauspieler, wird sterben

Joe Lara, ein Duplikat...

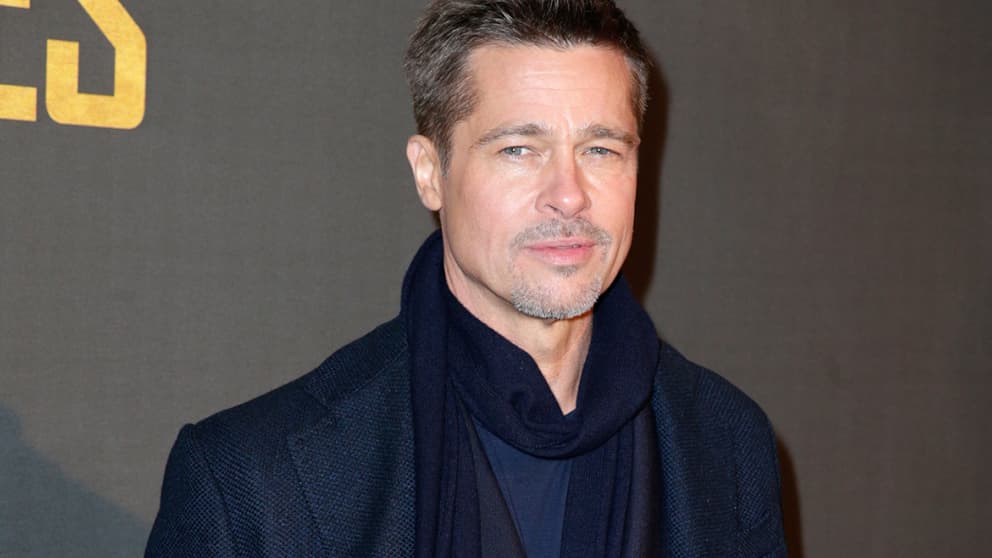

Richter Brad Pitt gewährt im Falle einer Scheidung von Angelina Jolie das gemeinsame Sorgerecht...

Laut der TMZ-Nachrichtenseite bestätigt das Urteil des pensionierten Richters John Oderkerk, der privat und nicht vor Gericht arbeitet, die Gültigkeit des Grundsatzes des gleichen...

„Eher im Einklang mit meinen Gedanken“: Julien Courbet beschloss, seine große Leidenschaft zu beenden

Auf den Kopf Das könnte dir geschehen, täglich auf M6, spielt Julien...

SCIENCE

COVID-19-Datenaktualisierung: Das Texas Medical Center gibt bekannt, dass es die endgültige...

HOUSTON, Texas (KTRK) – Zwei Jahre später gab das Texas Medical Center bekannt, dass es am Montag sein neuestes COVID-19-Datenupdate auf seinem Dashboard bereitgestellt...

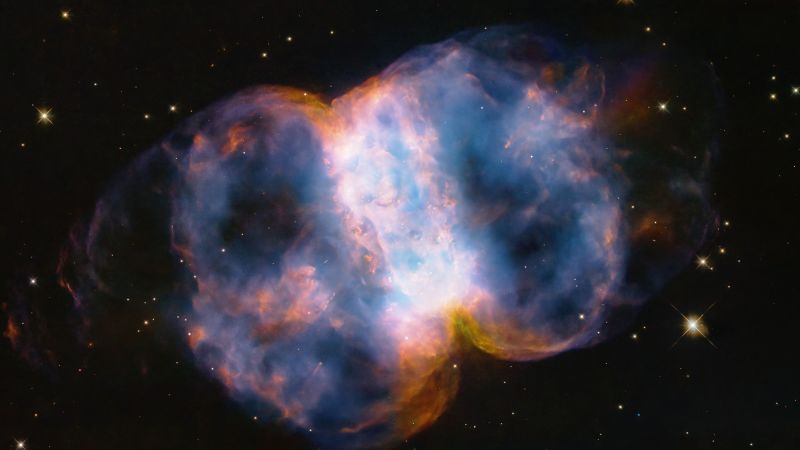

:quality(75)/cloudfront-us-east-1.images.arcpublishing.com/elcomercio/ZXU6INGHSFGVZMXKOLQBUFW7EI.jpg)