Hochrechnung

Tech

RCS-Gespräche sind jetzt Ende-zu-Ende-verschlüsselt

Mit RCS im Jahr 2019 reagierte Google auf...

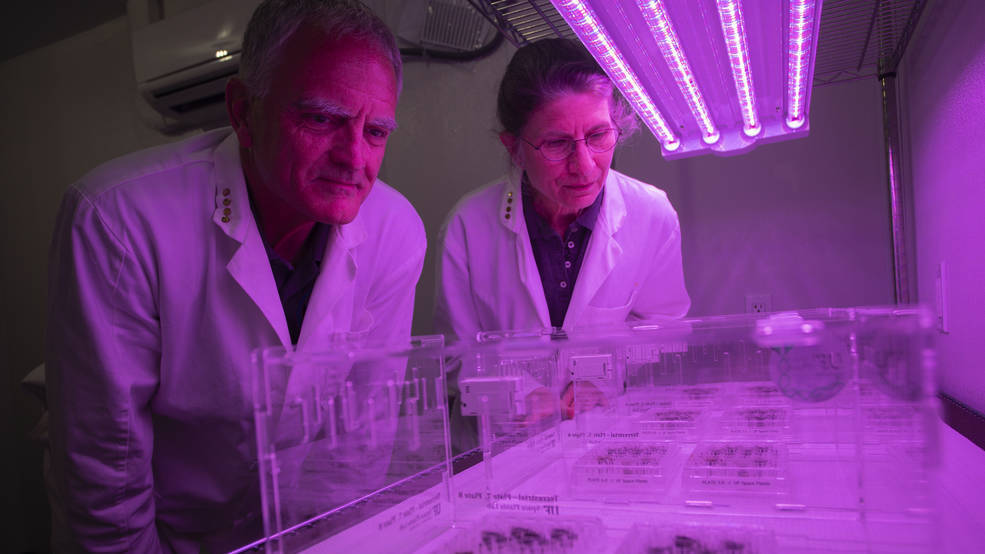

Veröffentlichte die erste vollständige Sequenzierung des menschlichen Genoms

Genom ist der vollständige Satz von Genen, die in einem Organismus vorhanden sind, oder der Satz diploider Chromosomen in eukaryotischen Arten.

Erstmals wurde die erste...

ECONOMY

Der deutsche Riese Lufthansa hat im Juli wegen Personalmangels 900 Flüge gestrichen

Der deutsche Luftfahrtgigant Lufthansa...

Die Wall Street ist von Gewinnmitnahmen betroffen und fällt an Rekorden vorbei

Veröffentlicht in: 19/04/2021 -...

Auf den Autobahnen zwischen Paris und der Normandie wird bis Ende 2024 eine barrierefreie Maut erhoben

Die Benutzer können mit der zulässigen Geschwindigkeit auf der Autobahn fahren, ohne zu verlangsamen oder anzuhalten,...

Geheimer Marsch im Vatikan – catholic.de

Hyazinthe, ein Faktor, der Barrieren zusammenhält. Taxifahrer fluchen. Die Straßen...

Android Apps – La Nouvelle Tribune kann installiert werden

Unter den vielen Neuerungen des neuen Betriebssystems Windows 11 angekündigt von Microsoft Berechnen Sie im Juni nächsten Monats die Möglichkeit, Android-Apps aus dem App...

Daft Punk… ist zurück auf Twitch, mit einer Wiederholung eines Konzerts

Neuer Glanz-Coup für das berühmteste Elektro-Duo der Welt: Genau ein Jahr nach der Bekanntgabe ihrer Trennung unterzeichneten die französischen Daft-Punk-Musiker am Dienstag ihr Comeback...

Schützen Impfstoffe auch vor dem langjährigen Coronavirus?

Foto: Oligari (Aktienkampf)Das Wichtigste, was COVID-Impfstoffe bewirken, ist, Todesfälle und schwere Erkrankungen durch COVID-19 zu verhindern. Die zweitwichtigste...

ENTERTAINMENT

Nach fast zwei Jahrzehnten hat sich Ben Affleck erneut für den Verlobungsring von Jennifer...

Ben Affleck und JLo im Urlaub in Italien (Foto © 2021 Backgrid UK / The Grosby Group)Ben Affleck, 49 Jahre alt Gefilmt suchen Verlobungsringe...

Taylor Swift sobre Damon Albarn: „Tu opinión es completamente falsa y muy dañina“ eint...

La cantante Taylor Swift no dejó pasar mucho tiempo y le respondió al músico inglés Damian Albarn, Königin señaló que la intérprete de „All...

Ed Sheeran wird den NFL-Kickoff präsentieren; Wo und wann siehst du

EFE und AP

Mexiko Stadt / 08.08.2021 16:25:20

...

3D-Tiger in „Fort Boyard“ machen Internetnutzern sprachlos (Video)

Film- und Fernsehkritik

Fernsehen

Gepostet...

NEUESTE ARTIKEL

Latest article

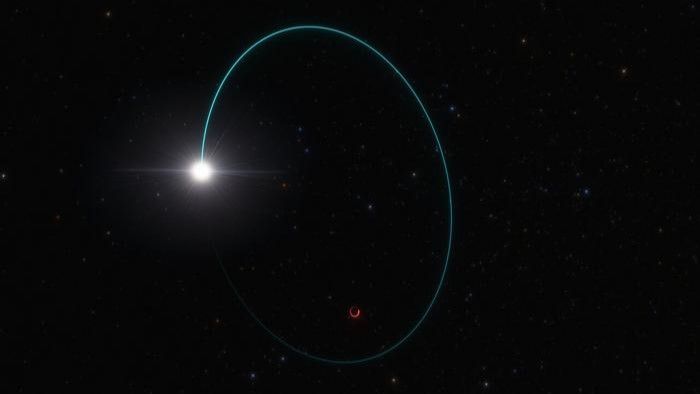

Ein massives stellares Schwarzes Loch, das in der Milchstraße entdeckt wurde, ist „extrem nah“...

Astronomen haben den massereichsten Sternhaufen entdeckt schwarzes Loch Es wurde in unserer Galaxie entdeckt – und lauert neuen Forschungsergebnissen zufolge „ganz nah“ an der...

Wann wird ETA Wassermann von seiner besten Seite sehen?

Bis zum 27. Mai, Höhepunkt in der Nacht vom 4. auf den 5. Mai.GTDer Eta-Aquariids-Meteorschauer hat begonnen und dürfte einer...

:quality(85)//cloudfront-us-east-1.images.arcpublishing.com/infobae/EHVB7BBKL5DB7J5GMZAAN6STGU.jpg)