Hochrechnung

Aamir sorgte beim größten Karaoke in Frankreich für Aufsehen

Seine Darbietung begeisterte das Publikum.

M6 Ausgestrahlt am Mittwoch, 29 Seine neue Show ist "Größtes Karaoke in Frankreich". Das ursprüngliche Programm löste eine Reaktion...

Tech

Bald Beta auf PS5?

Die Beta von Gran Turismo 7 wird bald für PS5 verfügbar sein. Sony muss dies noch bestätigen, aber auf der PlayStation-Website wurde eine...

Die NASA schlägt vor, Ihren Namen um den Mond reisen zu lassen

In einem Monat haben mehr als zwei Millionen Menschen ihren Vor- und Nachnamen registriert, um an der Artemis-I-Kreuzfahrt teilzunehmen, die im kommenden Juni starten...

ECONOMY

Was ist eine umgekehrte Einkaufsliste und wie hilft sie Ihnen beim Sparen?

Es besteht kein Zweifel, dass eines der tiefsten Geheimnisse des Menschen darin besteht, den besten Weg zum Überleben zu finden....

Google Pay: Sparen, bezahlen und verwalten

Google Pay ist eine sichere, einfache und nützliche Möglichkeit, Ihr Geld zu verwalten, und gibt Ihnen ein klareres Bild von Ihren Ausgaben und Ersparnissen:-...

Kein Kurs von Le Tour

Pre-Launch-Männer 108 Tour de FranceFrauen stehen am Samstagmorgen bei der achten Ausgabe von . im Rampenlicht Kurs von Le Tour de France. umstritten...

Was ist Bitcoin?

Bitcoin ist ein Test-Advanced-Geld, das jedem, überall auf der Welt, sofortige Raten ermöglicht. bitcoin-codenorway.com nutzt verteilte Innovation, um ohne Schwerpunkt zu arbeiten: Die Überwachung...

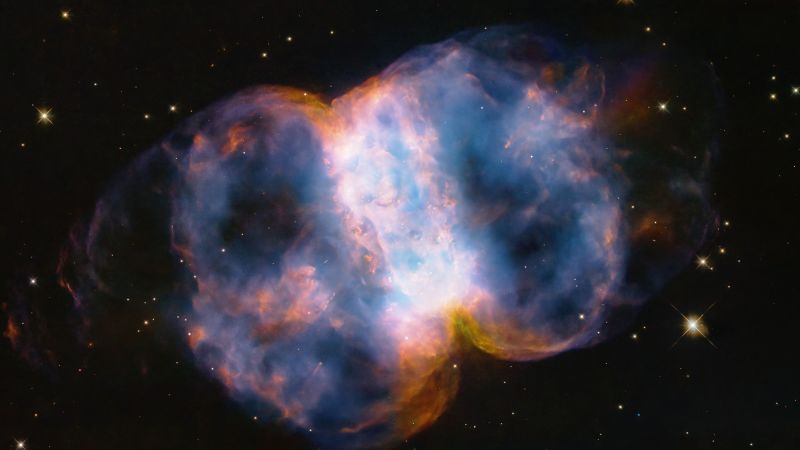

Die Inspiration4-Crew spricht mit Elon Musk, arbeitet an seinem ersten vollen Tag im Weltraum...

Eine Geschichte geschrieben für CBS-Nachrichten & mit Genehmigung verwendet

Ein Blick auf das Kuppelfenster der Raumsonde Crew Dragon Resilience von SpaceX. Bildnachweis: SpaceXSpaceX berichtete...

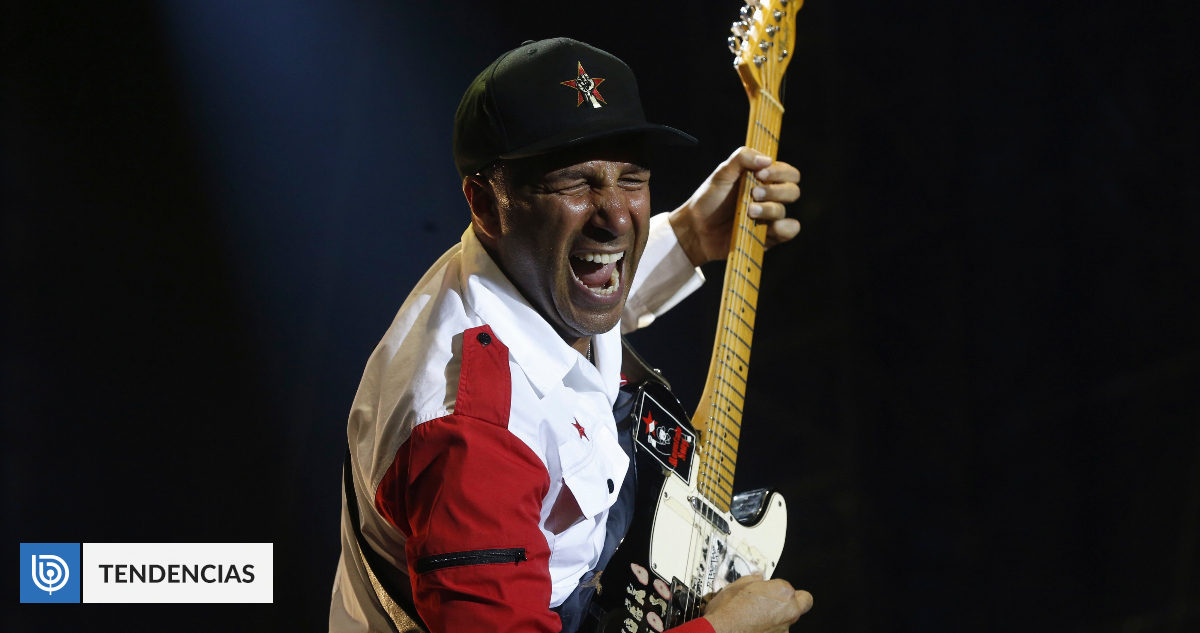

ENTERTAINMENT

Google Pay: Sparen, bezahlen und verwalten

Google Pay ist eine sichere, einfache und nützliche Methode zur Verwaltung Ihres Geldes und gibt Ihnen einen klareren Überblick über Ihre Ausgaben und Ersparnisse:-...

Vorhersagen von Jose Diez Canseco

Anschauen Horoskop Karte Von José Diez Canseco Für den Tag, Dienstag, 29. MärzUnd Sie können sehen, wie Ihr persönliches Leben, Ihre Liebe, Ihre...

Gwen Stefanis neuester Post enthüllt geheime Hochzeitsgerüchte

Nach fünf Jahren des Wartens darauf, dass Blake Shelton auf ein Knie fällt und Gwen Stefani einen Heiratsantrag macht, ist es im Oktober endlich...